Краткое саммари

В этом материале рассмотрим, как отличить ИИ-видео от настоящего. Несмотря на повышенную эффективность новых моделей, они до сих пор допускают ошибки, которые видны опытному пользователю. Мы расскажем про основные механизмы генерации видео с помощью нейросетей и способы их распознать. Также порекомендуем инструменты для автоматической проверки и чек-лист со всеми способами.

Кому будет полезно прочитать статью:

Авторам ИИ-видео. Одна из опасностей нейросетей кроется в их неэтичном использовании. Прочитайте эту статью, чтобы понять, чего лучше избегать в работе с ИИ.

Любым пользователям интернета. ИИ все глубже проникает в нашу жизнь, и становится все важнее уметь опознать его. Наша инструкция научит вас быть начеку и не верить дезинформации.

Содержание

К 2026 году вопрос, как отличить ИИ‑видео от настоящего, стал одной из главных тем в области искусственного интеллекта. Видео, созданные нейросетями, все чаще выглядят как реальные записи. Уже сами разработчики задаются вопросом — как мы будем отличать подделку от реальности? Собрали советы, которые помогут найти ответ на этот вопрос.

Как работают современные нейросети для генерации видео

Генерация видео — непростая задача. В отличие от статических изображений, здесь ИИ должен создавать сотни связанных с собой кадров и склеивать их в единую последовательность.

Долгое время нейросети не могли справиться с этой работой и выдавали ролики, полные галлюцинаций — типичных ошибок ИИ, когда модель на ходу меняет лица или одежду людей, приделывает им новые конечности или стирает объекты между кадрами.

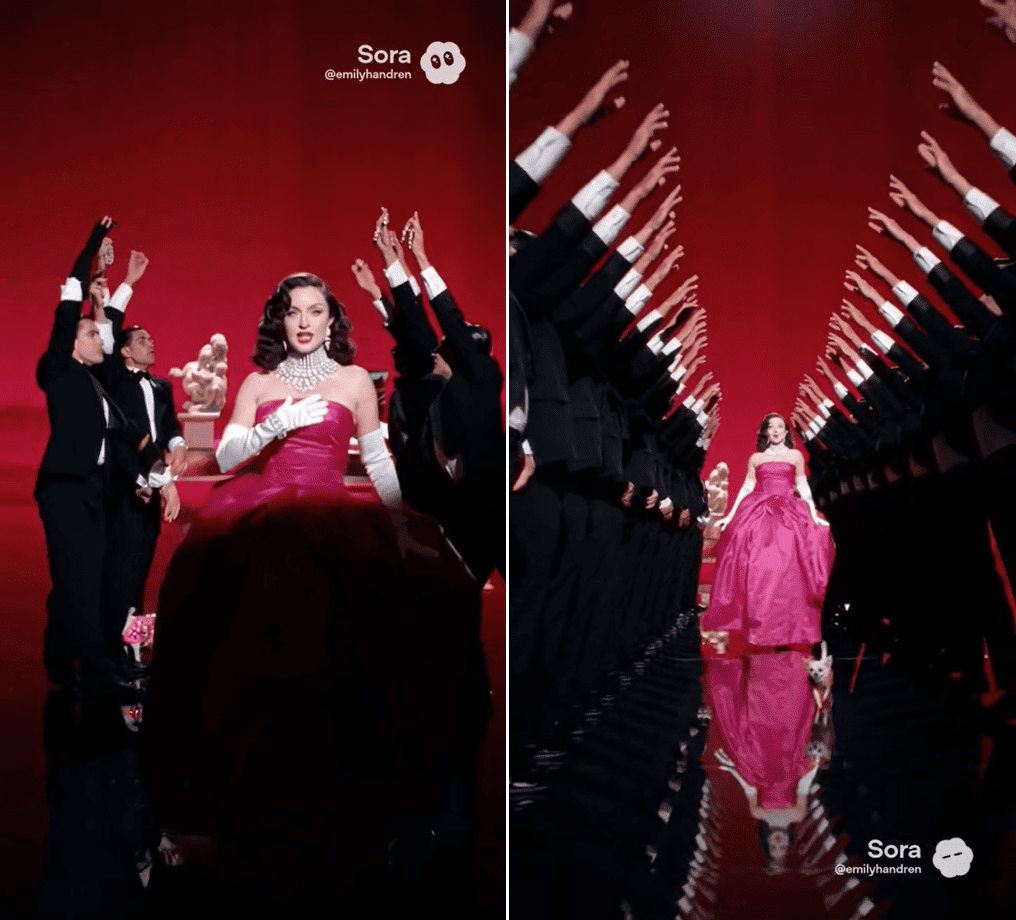

Большой прорыв случился в 2025 году. Практически одновременно в публичный доступ вышли Sora от Open AI, Veo3 от Google DeepMind и Runway Gen-4. Эти три модели вывели нейросетевое видео на совершенно новый уровень — теперь фейковый Уилл Смит наконец-то может нормально поесть лапши, а говорящие коты не вызывают первобытный ужас.

Создать свое видео с помощью Sora 2 можно в нашем ИИ-генераторе. Сервис поможет, когда нужно за короткий срок подготовить видео для соцсетей, презентации или лендинга, не привлекая дизайнеров и других специалистов.

Как ИИ это удалось? Изменился подход к самой генерации — после обновлений в деле участвуют сразу несколько алгоритмов, которые позволяют ИИ понимать текстовый запрос, создавать визуальную составляющую и отслеживать логику выдачи. Такое сочетание технологий называют термином «латентный диффузионный трансформер» (latent diffusion transformer). Разберемся, что значат эти слова.

Латентность — это скрытый процесс. В случае с нейросетями это означает, что ИИ не занимается полноценной генерацией каждого кадра, а просчитывает все в виде математической модели. Данные хранятся в виде кода, поэтому алгоритм может сначала распланировать все содержание будущего видео, а уже потом создать его итоговый вариант. Это сильно экономит ресурсы и ускоряет работу.

Диффузия — принцип работы, ставший традиционным для визуальных нейросетей. Во время обучения машине скармливают большой набор данных, заставляя ее искать уже знакомые объекты среди все большего количества цифрового шума. Генерация происходит в обратную сторону — когда мы просим ИИ показать нам какой-нибудь предмет, он воссоздает его образ из набора случайных пикселей.

Трансформер — алгоритм, который обеспечивает взаимосвязь элементов. Это предиктивная модель, которая обычно используется в текстовых ИИ — там она создает текст на основе того, какие слова чаще всего стоят рядом в заранее изученном массиве. Похожим образом это работает и в видео — трансформер подгоняет содержание соседних кадров друг под друга на основании контекста и собственных ожиданий.

Зачем уметь отличать сгенерированные видео от реальных

До появления обновленных моделей ИИ-видео не отличалось особой реалистичностью и качеством — очевидные артефакты мог увидеть даже неопытный зритель.

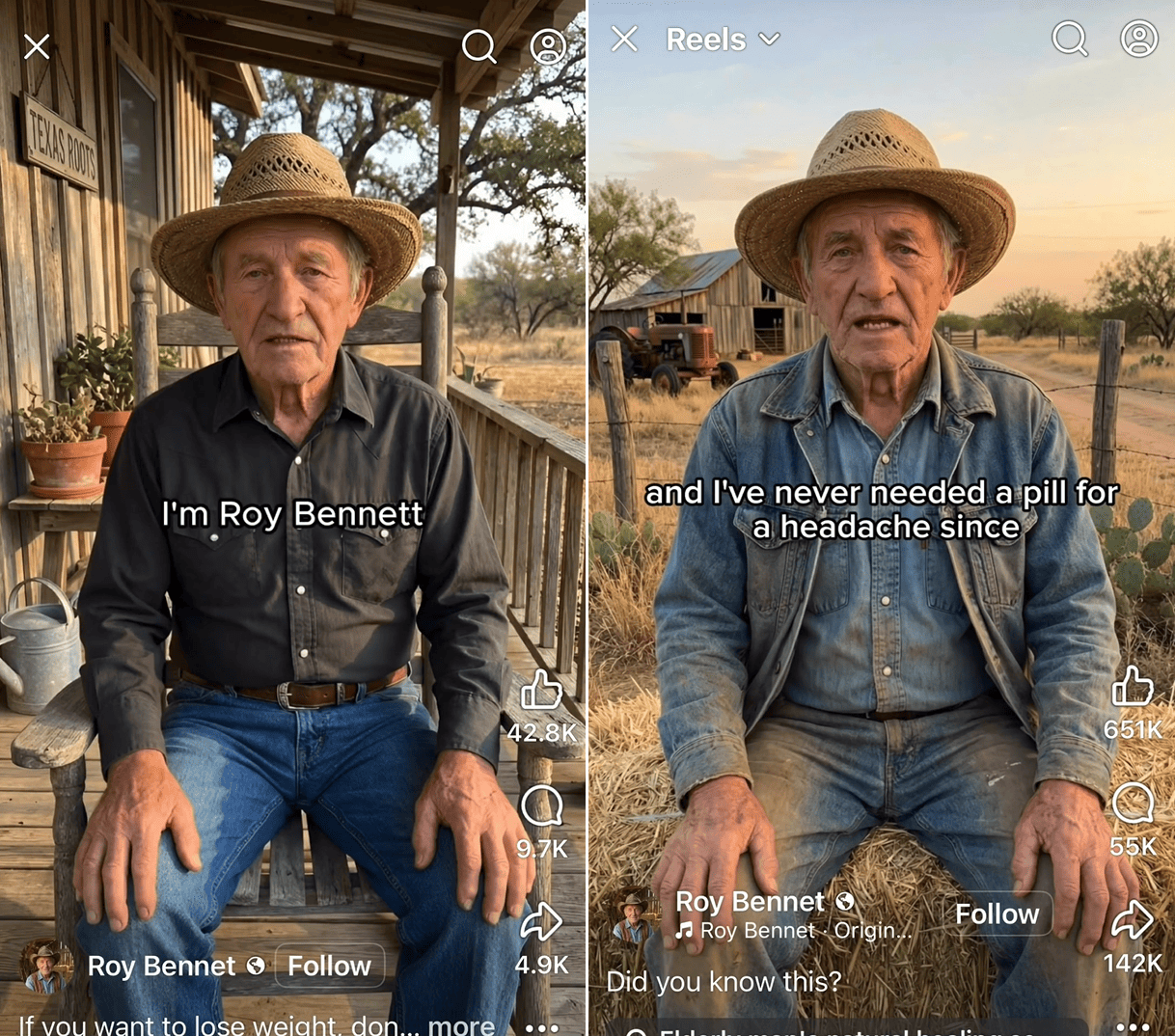

Диффузионные трансформеры изменили ситуацию — теперь соцсети наполнены потоком нейросетевых роликов, которые на первый взгляд могут показаться настоящими. А ленты соцсетей работают так, что второго, более вдумчивого взгляда может и не быть — пользователи листают бесконечный контент, нередко принимая за чистую монету все, что видят.

Это создает множество опасностей, например:

Угроза репутации — знаменитости и даже обычные люди могут стать невольными героями видео, в которых делают незаконные вещи или выходят за рамки приличий.

Подмена личности — мошенники могут создать цифровую копию человека и использовать ее для вымогательства денег у родственников или звонков в банк.

Искажение фактов — нейросети открывают широкий простор для убедительных доказательств конспирологических теорий, а фейковые документальные кадры реальных событий позволяют манипулировать общественным сознанием.

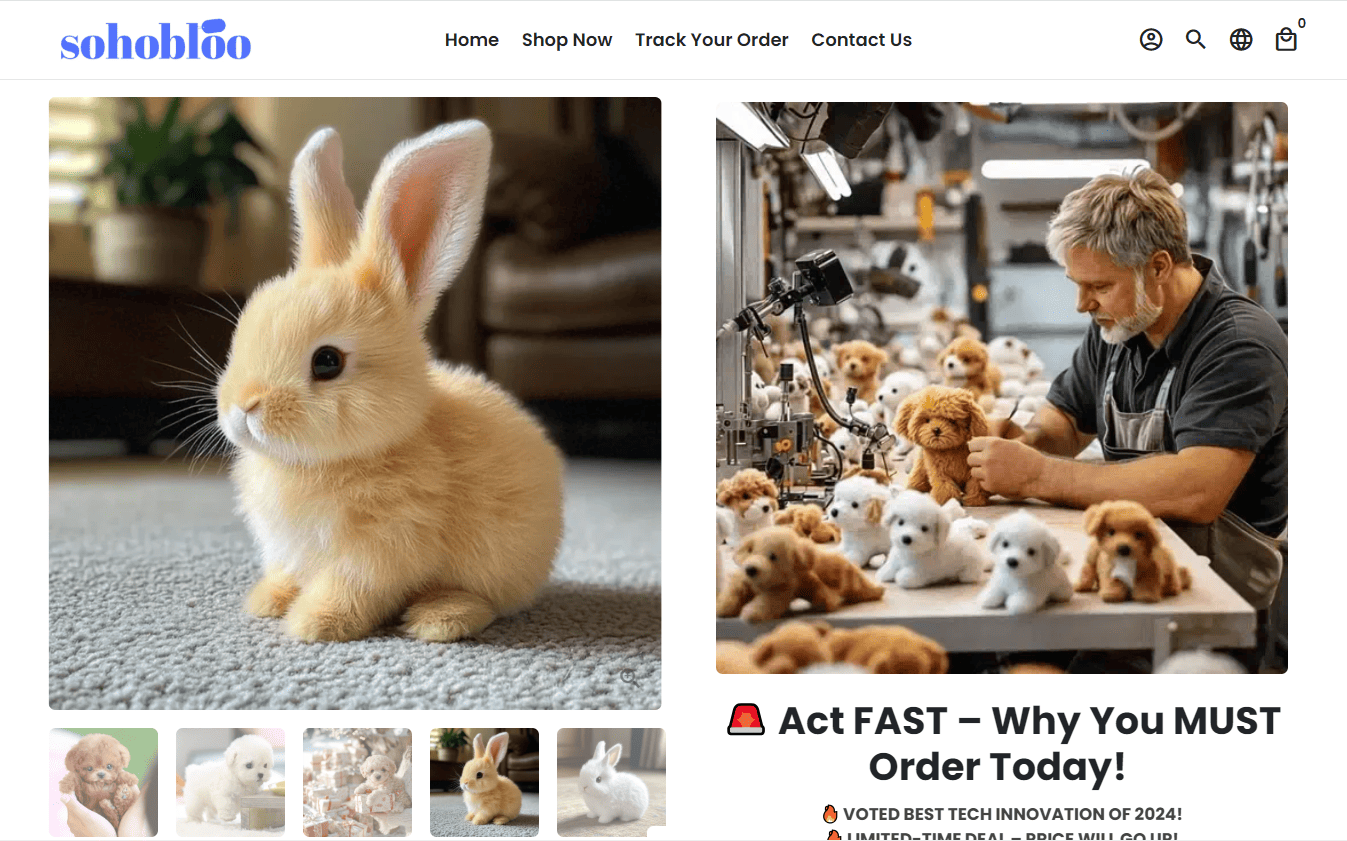

Нечестный маркетинг — слишком идеальные изображения товаров и реакций на них заставляют потратить деньги на что-то низкокачественное или вовсе несуществующее.

Под удар попадают люди, лишенные критического мышления и мало следящие за собственной цифровой гигиеной — в основном это дети и пенсионеры. Но даже опытные интернет-пользователи не защищены от фейков и обмана.

Технологии развиваются, область их применения растет, а остаться с носом не хочется никому. Вот почему каждый пользователь сегодня должен понимать, как проверить видео на подлинность и вовремя распознать дипфейк‑видео.

FAQ: как защититься от дезинформации

Все ИИ-видео — фейк и обман?

С точки зрения авторского права и морали ИИ остается в серой зоне. Но далеко не все пользуются нейросетями со злым умыслом — кто-то таким образом заменяет традиционное творчество, кто-то — просто создает относительно безобидный контент для соцсетей.

Почему использование ИИ в рекламе может стать проблемой?

Законы многих стран стремятся заставить рекламодателей рассказывать о себе честно. С помощью нейросетей реальность часто приукрашивают — добавляют в карточки яркие картинки, а после заказа мы получаем совсем не то, что ждали. Есть риски не просто неоправданных ожиданий, а настоящего обмана — когда ИИ-ролики показывают как доказательство существования ненастоящих товаров.

Как распознать ИИ‑видео и отличить его от настоящего

Хотя нейросети научились генерировать очень детальные и правдоподобные видео, в них до сих пор остаются характерные признаки ИИ. Одни из них можно распознать моментально, другие — только при доскональном изучении каждого кадра или даже самого видеофайла.

В этом разделе мы разберем основные признаки видео, созданного ИИ, которые помогут понять, является ли ролик подделкой или реальной съемкой. Гарантируем, что знание этих признаков превратит вас в опытного нейросетевого детектива.

Малозаметные изменения и «призраки»: что искать в кадре

С помощью трансформеров удалось достичь устойчивой последовательности содержимого видео, но технология работает не идеально.

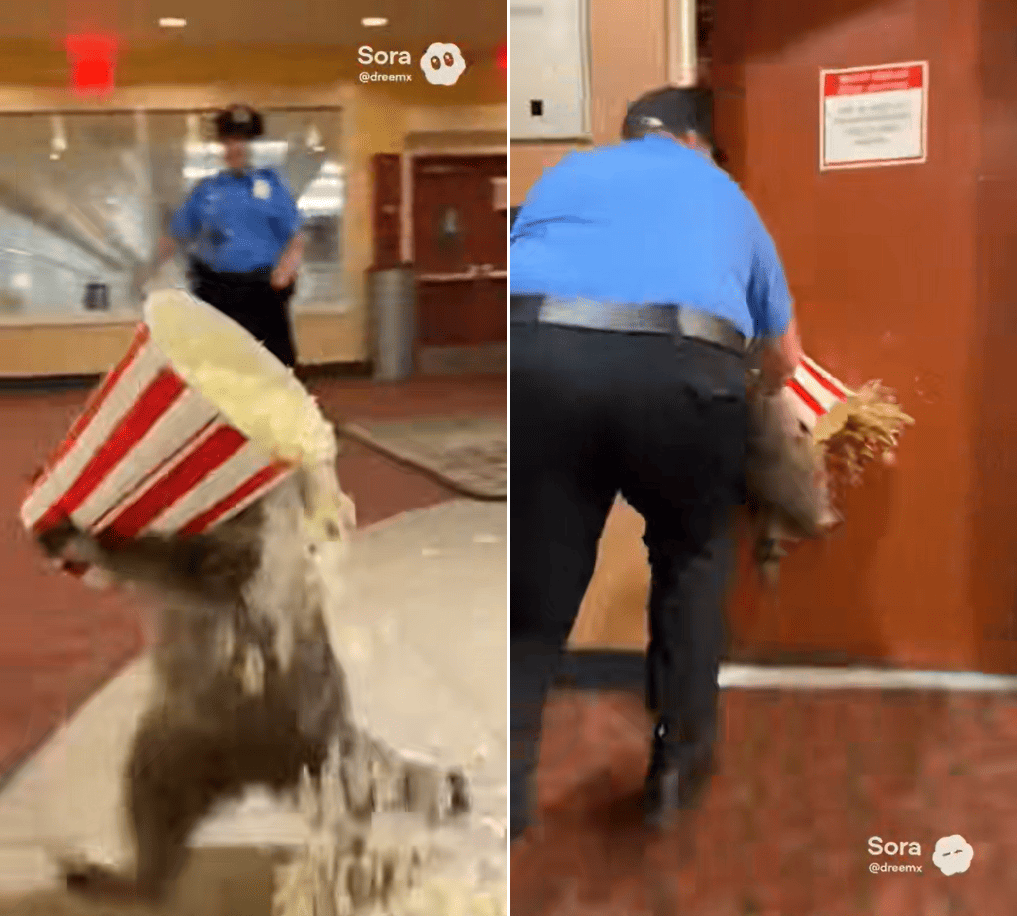

ИИ до сих пор тяжело даются моменты, когда объект уходит из кадра даже на доли секунды — непрерывность контекста обрывается, и какие-то элементы приходится создавать заново. Тогда целостность образов нарушается, и герои на ходу могут переодеваться, менять внешность или оказываться в других локациях.

Вот пара частых примеров:

Когда на экране присутствует говорящий человек, его губы постоянно движутся. Пока рот закрыт, нейросеть забывает, какие зубы смоделировала в прошлый раз, и начинает генерацию с нуля — может отличаться их форма, ширина и направление роста.

Если на заднем фоне проходит человек, который скрывается за головой спикера, мы ждем его появления с другой стороны. Но за короткое время нейросеть успевает забыть о его существовании и просто стирает его из бытия.

То же самое происходит с одеждой, зданиями и природой, когда камера движется и теряет их из своего вида. Модель старается сохранять контекст — описание окружения или внешнего вида героев — но уже не повторяет в точности то, что создала в первый раз.

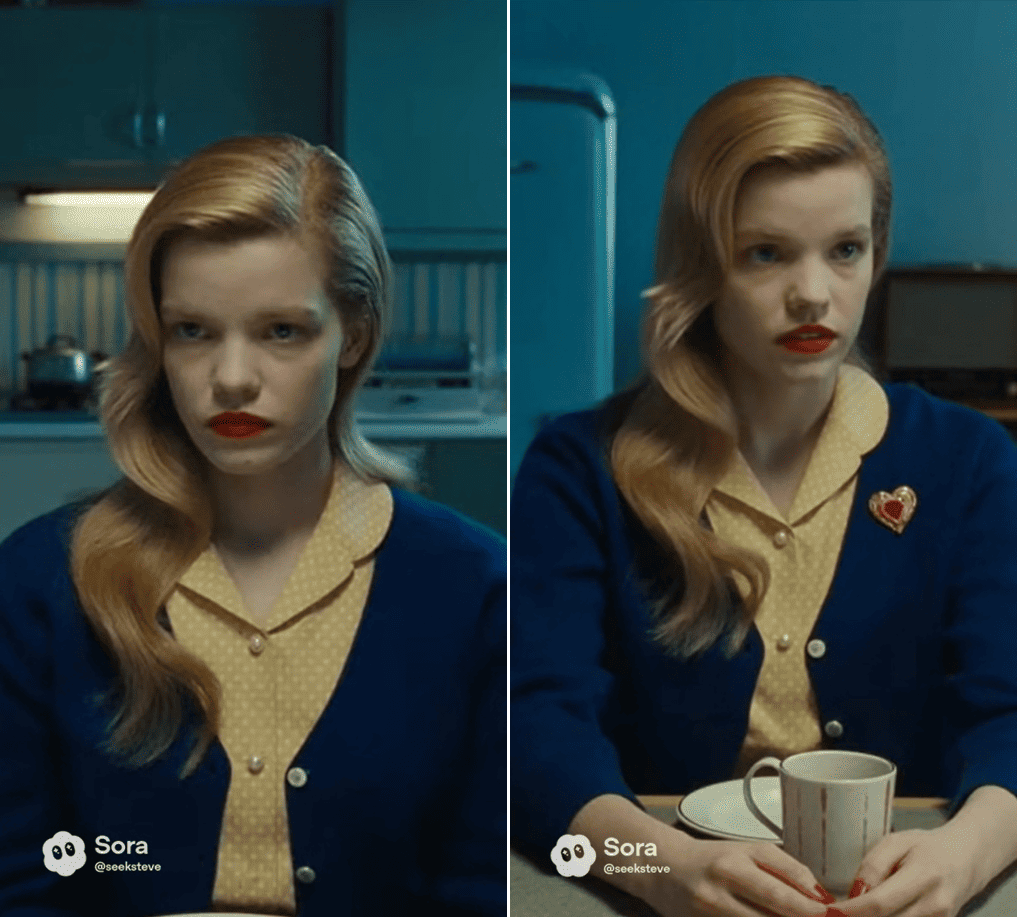

Исчезающие между кадрами объекты называют «призраками» — они как будто проходят сквозь стены и растворяются в пространстве. Чтобы их поймать, приглядитесь ко второму плану и краям кадра — все ли выглядит так же, как пару секунд назад? А если вы вдруг заметили, что за время отсутствия в кадре персонаж отрастил усы или успел примерить рубашку вместо футболки, не сомневайтесь — перед вами нейровидео.

Пальцы, очки и мелкие элементы: типичные признаки ИИ‑видео

Анатомия рук продолжает оставаться главным камнем преткновения нейросетей. Сами по себе пальцы более-менее удаются, но передать их в движении могут не все модели. Из-за этого руки могут выглядеть как непонятные сгустки материи, только отдаленно напоминающие реальные конечности. Поэтому среди ИИ-видео популярна имитация съемки на селфи-камеру, интервью крупным планом или статичные позы — так руки все время остаются на месте или вовсе не видны.

Очки и стекла — еще одна проблема, с которой ИИ еще только предстоит разобраться. В реальности линзы создают искаженную перспективу, визуально увеличивая или уменьшая глаза носящего их человека, а на самих стеклах видны блики, которые ИИ сложно передать достоверно. Нейросети плохо работают и с отражениями — они генерируют их как отдельные объекты, а это значит, что они будут отличаться от оригинала.

ИИ не всегда справляется с мелкими деталями — пуговицами, часами, украшениями. Они сливаются друг с другом, их текстуры накладываются на соседние, они могут просто висеть в воздухе или казаться плоскими. Похожим образом ведет себя и текст — абсурдные вывески, книги и газеты продолжают оставаться одним из самых очевидных маркеров ИИ.

Фоновые объекты и окружение: как отличить фейковое видео от настоящего

Часто в ИИ-роликах можно встретить очень низкую глубину резкости с размытым окружением. Когда в фокусе только основной объект, окружение требует меньше проработки — мы все равно почти не обращаем внимания на эту область. Там-то и скрываются одни из основных примет ИИ: деформация объектов, «призраки» и непоследовательный рендеринг.

Присмотритесь к тому, что происходит на заднем плане. Прохожие сливаются в огромное пятно? Персонажи окружены вещами, точное назначение которых трудно представить? Фон меняется при каждом переходе кадра? Значит, вы смотрите сгенерированный ролик.

Освещение и «аура ИИ»: вырванные из окружения объекты

«Аура ИИ» возникает из-за механизма диффузии — так как каждый объект появляется из набора пикселей, какое-то количество цифрового шума может остаться в итоговом видео. Такие дефекты можно заметить вокруг объектов и персонажей — на самой границе между ними и фоном может быть видна деформация или хаотично движущиеся пиксели.

Выдать нейросеть может и рендеринг света — направление теней часто не совпадает с источниками освещения. Иногда объекты могут быть подсвечены слишком равномерно, как будто свет падает со всех сторон. Такие видео кажутся наиболее неестественными — мы привыкли, что в реальности такое встречается только в постановочных ситуациях или в компьютерной графике.

Эффект «зловещей долины»: когда жуть берет

Через «зловещую долину» пытаются перешагнуть любые создатели 3D-графики, робототехники и прочих технологий, способных имитировать человека. Это психологический эффект, который заставляет нас испытывать дискомфорт, когда мы видим что-то, очень похожее на нас, но ведущее себя не совсем как человек. Ученые приписывают «зловещей долине» роль защитного механизма, который бережет нас от опасных чужаков — очень полезная вещь в эпоху, когда что угодно может заставить нас сомневаться в реальности.

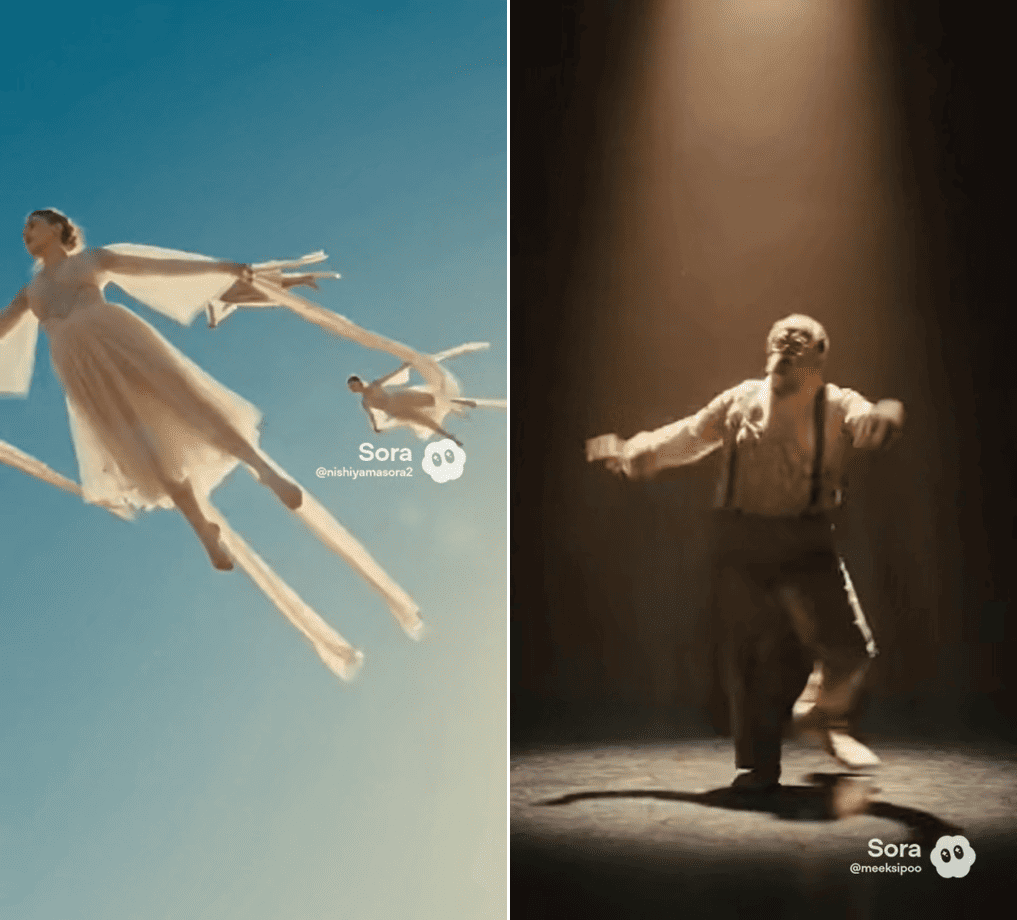

«Зловещую долину» могут вызвать ситуации, когда персонажи ощущаются не как живые люди, на которых действуют законы физики. Такие вещи часто используются в хоррорах, например:

движения как в ускоренной съемке или обратной перемотке;

эффект марионетки — человек подвешен в пространстве и неестественно дергает руками и ногами;

нарушения анатомии — позвоночник выгибается в обратную сторону, конечности становятся слишком прямыми или как будто желейными.

Эмоции и мимика: слишком плавные или неестественные реакции

Этот признак отчасти похож на эффект «зловещей долины», но не всегда вызывает такое же отторжение. Люди на видео могут недостаточно сильно реагировать на происходящее и, например, оставаться полностью расслабленными во время драматического разговора об отношениях. Бывает и наоборот — вместо обычной реакции на шутку человек гипертрофированно смеется, как на стоковых фотографиях, изображающих веселье.

Другой явный признак нейросети — в рамках одного кадра все персонажи, скорее всего, будут выражать похожие эмоции и настроение. Для ИИ свойственно переносить описание одного персонажа на других, а чтобы этого избежать, нужно очень тщательно формулировать промпты — но и это не дает стопроцентной гарантии.

Аудиодорожка: несоответствия голоса, шумов и синхронизации

Не все модели способны генерировать аудио — в таких случаях звук на видео приходится накладывать отдельно, и любые расхождения можно считать признаком подделки.

Нейросети, которые генерируют видео сразу со звуком, тоже вычислить довольно легко. Прислушайтесь и проверьте эти признаки:

Слишком низкое качество аудио — слышны звуковые артефакты, как при прослушивании плохих mp3-файлов.

Рассинхронизация действий и их озвучки — звуки могут опаздывать или торопиться.

Неестественная речь — слишком низкая выразительность, механичность и равномерность голосов, отсутствие пауз и эмоциональных оттенков.

ИИ-музыка — нейросеть может создать свой саундтрек, который будет обладать похожими признаками, в том числе булькающим звуком, нелогичной структурой и резкими обрывами в начале или конце.

Соотношение сторон и низкое качество: технические индикаторы

Скорость работы всегда была одним из факторов популярности ИИ. Большинство видео генерируются с соотношением сторон 9:16 — это вертикальный формат, привычный для смартфонов и соцсетей. Такие ролики можно сразу загрузить в сторис, не тратя время на обрезку в редакторе.

Но у такого удобства есть обратная сторона — низкое качество. Ролики создаются в невысоком разрешении и выглядят как чрезмерно сжатое и перезалитое видео. У этого сразу несколько причин:

Владельцы нейросетей сокращают вычислительную нагрузку на сервера и экономят ресурсы.

В массивах данных для обучения может оказаться множество таких же низкокачественных видео из соцсетей.

Смазанность картинки позволяет маскировать ошибки генерации и деформацию объектов.

Как правило, улучшенное качество и более высокое разрешение файлов доступны платным пользователям ИИ, но даже тогда остаются некоторые артефакты рендеринга.

Анализ структуры и стилистики: повторяющиеся паттерны в видео

Хоть ИИ и обучаются на довольно объемной базе примеров, ее разнообразие ограничено. Даже в настоящем кино приняты определенные планы и структура кадра. То же самое можно сказать и про соцсетевой контент — сколько раз в день мы видим говорящие головы на фоне стены, панорамы достопримечательностей или крупные планы свежей покупки?

Нейросети запоминают то, что видят чаще всего — а когда получают промпт, стараются максимально приблизиться к их представлению об описанных понятиях. В итоге ИИ выдает нечто среднестатистическое на заданную тему, особенно если задача была сформулирована слишком поверхностно.

Свою роль здесь играют и пользователи. К ИИ нередко обращаются, чтобы присоединиться к трендам или запустить свои собственные — это создает очередные итерации уже знакомого контента, пусть и в неожиданной форме.

Еще нейросети помогают оживить фантазии или примерить на себя роль режиссера. Поэтому в роликах мы часто видим нереалистичные сюжеты, подражание знакомым архетипам и имитацию стилей различных студий.

Метаданные и происхождение файла: ищем подсказки в свойствах

ИИ-контент регулируется все тщательнее. Разработчиков нейросетей постепенно обязывают применять решения, четко указывающие на то, что картинки или видео были сгенерированы.

Самый простой способ пометить видео — добавить вотермарку с логотипом компании. Их, например, видно на большинстве скриншотов в этой статье, взятых с основного сайта Sora. Но вотермарки не назвать надежной защитой от фейков — пользователи могут убрать их, перейдя на платный тариф или воспользовавшись сторонними инструментами.

Здесь на выручку приходят метаданные — информация внутри самого файла, в которой указан источник видео. Проверить их можно с помощью специального инспектора или в свойствах файла на компьютере.

Но и эти метаданные можно переписать — вручную или перерендерив ролик в видеоредакторе. Большая часть аудитории нейросетей вряд ли пойдет на такие хитрости, но более продвинутых пользователей это не остановит. Если вы сомневаетесь, можно ли доверять ИИ‑видео, всегда проверяйте файл по нескольким признакам сразу, а не только по описанию.

Подпишитесь на нашу рассылку — раз в неделю будем отправлять на ваш email свежую статью из блога и другие полезные материалы.

💌 Еженедельная рассылка

Фактчекинг и поиск источников: как быстро проверить, что перед вами оригинал

Нашли видео на резонансную тему, но не уверены, можно ли ему доверять? Первое правило цифровой гигиены — фактчекинг всего, с чем вы сталкиваетесь в интернете.

Проверьте информацию, которую вам сообщает автор ролика. Используйте поисковики, чтобы найти достоверные статьи по теме, прочитайте недавние новости. Загляните в комментарии — если видео фейковое, велика вероятность того, что кто-то на это уже указал.

В случае с рекламой постарайтесь разыскать страницы товара в онлайн-магазинах с хорошим рейтингом, проверьте отзывы и реальные фото покупателей. Когда вам пытаются продать что-то, что выглядит слишком идеальным, скорее всего вас собираются обмануть.

Не стесняйтесь обращаться за помощью к знающим людям — друзьям, родственникам или другим пользователям. Среди ваших знакомых может быть кто-то, кто хорошо владеет фактами на тему видео или отличает ИИ с первого взгляда. А в соцсетях сейчас много энтузиастов, не дающих спуску нейросетям — например, есть целый сабреддит, посвященный анализу подозрительного контента.

Использование ИИ-детекторов: бесплатные инструменты и их ограничения

Там, где не справляются другие методы, могут помочь сайты с детекторами ИИ. Для работы с ними вам нужно скачать видео из оригинального источника, загрузить его на сайт и запустить проверку.

Таких инструментов сегодня множество, и все работают по схожему принципу — используют те же нейросети, чтобы проанализировать признаки использовании ИИ для генерации видео.

Мы протестировали несколько результатов из выдачи Google по запросу «детектор ИИ видео». К нашему удивлению, инструментов, которые не требуют регистрации и при этом смогли выполнить свою задачу, оказалось всего два.

Инструмент | Особенности и ограничения | Результаты |

Поддерживает большое количество форматов картинок, видео и аудио, доступен в виде расширения для Google Chrome. | Уверенно определяет нейросетевое видео и распознает модель, в которой оно было сгенерировано. При этом может не узнать ИИ-аудио, даже если это очевидно на слух. | |

Принимает только основные видеоформаты — MP4, MOV, AVI, MKV и WEBM. | Достоверно распознает ИИ-видео, но показывает только процент своей уверенности — никакой дополнительной информации. |

FAQ: как отличить фейковое видео от настоящего

Можно ли определить видео, сгенерированное нейросетью, на глаз?

Ищите характерные признаки — ошибки рендеринга, непоследовательность образов, визуальные и звуковые артефакты. Доверяйте чувству реальности — если что-то кажется неправильным, стоит проверить контент более пристально.

Как определить дипфейк‑видео?

Обратите внимание на несоответствие мимики, голоса, освещения и контекста происходящего. Дипфейки часто выглядят правдоподобно на первый взгляд, но выдают себя деталями.

Всегда ли низкое качество видео является признаком ИИ?

Не всегда. Вертикальный формат и пережатое видео — обычные явления для соцсетей. Чтобы не ошибиться, ищите другие характерные приметы и сопоставляйте содержание видео с реальностью.

Как проверить видео на ИИ‑генерацию бесплатно?

Некоторые файлы могут содержать метаданные, указывающие на происхождение видео. Если их нет, попробуйте загрузить ролик в один из онлайн-инструментов для проверки ИИ.

Практический чек-лист: как проверить видео на ИИ за 15 шагов

Этот чек‑лист поможет вам понять, как определить видео, созданное нейросетью, без специальных инструментов (почти).

Оцените реальность происходящего — действительно ли это могло быть снято на видео?

Последите за одеждой, пальцами и зубами говорящего — замечаете ли вы деформации или искажения?

Прислушайтесь к аудио — ищите ошибки синхронизации, неестественную речь и бульканье.

Обратите внимание на мимику, эмоции и движения — ведут ли себя так реальные люди?

Прислушайтесь к себе — ощущаете ли вы эффект «зловещей долины»?

Присмотритесь к фону, попробуйте найти «призраки» и меняющееся окружение.

Найдите источники света и сопоставьте их с тенями, поищите «ауру ИИ».

Проверьте, можно ли выбрать качество видео — настоящий ролик должен быть доступен в высоком разрешении.

Сопоставьте факты с тем, что вам известно — не пытаются ли вас обмануть?

Вспомните похожие ролики — возможно, кто-то использует один и тот же шаблон.

Тщательно проверьте логику монтажа, структуру кадра, мелкие движения на фоне.

Еще раз прислушайтесь к аудио: есть ли фоновые шумы — бытовые приборы, ветер, звуки машин или птиц?

Проведите фактчекинг по ключевым словам — реальны ли события и факты, показанные в видео.

Проверьте комментарии, посоветуйтесь с друзьями или попросите помощи у экспертов.

Скачайте видео, проверьте его метаданные или загрузите в инструмент для проверки.

Прогнозы развития нейровидео и советы по цифровой гигиене

Развитие нейросетей продолжается, и впереди нас ждет только улучшение алгоритмов и способов их применения. В 2025 году мы увидели большой скачок в качестве генерации и возросшую автономность ИИ-агентов — возможно, через пару лет и это будет казаться чем-то примитивным.

В то же время, крупные онлайн-площадки все более ответственно относятся к защите от нейросетевого контента — появляются требования об обязательной маркировке, а нарушителей банят или лишают монетизации. Постепенно регуляционные меры готовятся и на государственном уровне — полноценные законы об ИИ в ближайшее время должны будут представить как в Европе, так и в России.

Совсем скоро умение отличать сгенерированное ИИ‑видео от настоящего станет таким же базовым навыком, как проверка фактов. А пока что всем, кто стремится обезопасить себя, стоит соблюдать правила цифровой гигиены:

Не берите на веру любую информацию. Сейчас легко подделать не только факты, но и их источники. Доверяйте только тому, что выдерживает полноценный фактчекинг.

Берегите свою личность и персональные данные. Транслировать всю свою жизнь в соцсети уже давно небезопасно — каждое селфи становится еще одним объектом для тренировки нейросетей. Чтобы оградить себя от мошенников, пересмотрите свое поведение в соцсетях и пользуйтесь надежными паролями и двухфакторной аутентификацией.

Проверяйте свои контакты. Когда вас неожиданно зовут в видеочат или отправляют кружочек в мессенджере с просьбой о финансовой помощи, поищите признаки нейросетей. Выйдите на прямой контакт с человеком, от лица которого получили сообщение, и подтвердите, что это правда был он.

Развивайте критическое мышление. ИИ пользуются все — мошенники, блогеры и простые пользователи. Не ищите во всем признаки фейков, но не позволяйте обманывать себя.

Чем раньше вы научитесь понимать, как отличить поддельное видео от настоящего, тем сложнее будет вас обмануть — даже с помощью самых современных нейросетей.

Почитать по теме:

Топ-12 лучших нейросетей для создания видео: сравнение, цены, обзоры