Содержание

- Краткое саммари

- Зачем использовать ИИ для создания видео и кому это пригодится

- Sora 2

- Google Veo 3.1

- Vidu

- Runway Gen-4.5

- Stable Video Diffusion

- Hailuo

- Kling AI

- Luma Dream Machine

- Wan AI

- Genmo Mochi

- Kandinsky

- Шедеврум

- Как правильно составлять промпты для генерации видео

- Частые ошибки при составлении промптов для генерации роликов

- Сравнение нейросетей для генерации видео

Краткое саммари

В 2026 году рынок нейросетей для генерации видео достиг $946 миллионов и продолжает расти. Лидеры — Sora 2 (OpenAI) с видео до 60 секунд и функцией "Камео", Google Veo 3.1 с 4K-качеством и возможностью склеивать ролики до 148 секунд, а также Runway Gen-4.5 с продвинутым контролем движения. Новые игроки — Luma Dream Machine 1.6 с поддержкой 3D-моделей и Wan AI от Alibaba для качественной генерации лиц. Цены варьируются от бесплатных версий (Sora 2 — ~5 генераций в день) до $200/месяц для профессиональных тарифов.

Кому стоит прочитать эту статью

- Маркетологам и SMM-специалистам — узнаете, какие нейросети лучше всего подходят для быстрого создания контента для соцсетей

- Владельцам малого бизнеса — найдете инструменты для создания рекламных и презентационных роликов без привлечения агентств

- Блогерам и контент-мейкерам — получите обзор лучших AI-генераторов видео 2026 года с актуальными ценами и возможностями

- Видеографам и режиссерам — узнаете о новых функциях профессиональных инструментов (Runway Gen-4.5, Veo 3.1) для кинематографических проектов

- Разработчикам — найдете open-source решения (Genmo Mochi, Stable Video Diffusion) для интеграции в свои проекты

Нужно быстро создать видео, а времени, навыков или бюджета нет? На помощь придут нейросети. Инструменты на основе ИИ уже умеют генерировать видео с нуля, озвучивать ролики, убирать шум, стабилизировать картинку, подставлять голос или переводить речь на другой язык.

В 2026 году технологии шагнули еще дальше: появились модели с поддержкой 4K, длинных роликов до 60 секунд и даже функциями вставки себя в видео.

Зачем использовать ИИ для создания видео и кому это пригодится

Создание ролика — процесс не самый быстрый и простой. Нужно писать сценарий, снимать, монтировать, озвучивать. А если добавить сюда цветокоррекцию, работу со звуком и анимацию — можно потратить недели, а то и месяцы.

По крайней мере, так было раньше. С появлением ИИ многое стало легче. Теперь достаточно одной идеи — и нейросети для видео онлайн воплощают ее в жизнь. В 2026 году технологии шагнули еще дальше: появились модели с поддержкой 4K, длинных роликов до 60 секунд и даже функциями вставки себя в видео.

Кому пригодятся ИИ-инструменты для генерации видео?

Маркетологам и SMM-специалистам — чтобы делать ролики для соцсетей быстро и в больших количествах.

Малому бизнесу — для презентаций, рекламы и обучающих роликов без привлечения агентств.

Блогерам и авторам контента — чтобы прокачать качество контента и упростить монтаж.

Преподавателям и коучам — для записи и оформления обучающих роликов.

HR-специалистам и рекрутерам — чтобы делать короткие видео о вакансии или онбординг-ролики.

Видеографам и режиссерам — для создания концепт-видео, превью и быстрых прототипов.

Просто людям с идеями — ведь теперь, чтобы создать видео, не нужно быть продюсером.

FAQ по использованию ИИ для создания видео

Могут ли нейросети полностью заменить видеографов?

Пока нет. Нейросети отлично подходят для быстрого создания коротких роликов, концепт-видео и контента для соцсетей. Но для сложных профессиональных проектов, требующих точного контроля и творческого подхода, все еще нужны видеографы. ИИ — это мощный инструмент, который дополняет, а не заменяет профессионалов.

Сколько стоит создание видео с помощью нейросетей?

Цены варьируются от бесплатных версий (Sora 2 — ~5 генераций в день, Kandinsky — бесплатный API) до $200/месяц для профессиональных тарифов. Большинство инструментов предлагают бесплатные тарифы с ограниченными лимитами для тестирования.

Какое качество видео можно получить с помощью нейросетей?

В 2026 году лучшие модели (Google Veo 3.1, Sora 2) генерируют видео в 4K-качестве. Большинство инструментов создают ролики в HD (1080p) или Full HD. Качество зависит от выбранной нейросети и тарифа.

1. Sora 2 — лучшая нейросеть для генерации видео в 2026 году

Если вы хоть немного интересуетесь нейросетями, то наверняка слышали про Sora — флагманский инструмент от компании OpenAI для генерации видео. В 2026 году вышла вторая версия модели, которая значительно превзошла первую по качеству и возможностям. Его активно обсуждают маркетологи, креаторы, предприниматели и просто фанаты технологий.

Sora 2 — это ИИ для генерации видео, которая создает реалистичные ролики до 60 секунд по обычному текстовому описанию. Работает на базе GPT и других моделей OpenAI. Главное отличие от первой версии — улучшенная физика движения, встроенная генерация звука и новые функции редактирования.

Sora 2 умеет:

создавать видео из текстового запроса на английском длиной до 60 секунд,

генерировать сцену целиком с идеальной физикой и синхронизированным звуком,

редактировать уже готовые ролики, менять детали, продлевать сцены или делать зацикленные фрагменты,

использовать функцию "Камео" — вставлять себя в видео,

применять "Remix" для изменения деталей в уже созданном ролике,

подбирать шаблоны, стили, соединять разные фрагменты и управлять композицией с помощью функции Storyboard.

Sora 2 особенно хороша в создании пейзажей, абстрактных паттернов и мультяшных роликов. Видео с людьми и животными получаются более реалистичными, чем в первой версии, благодаря улучшенной физике. Если вы хотите добиться кинематографического эффекта или создать вау-ролик для соцсетей, Sora 2 справится лучше конкурентов.

Тарифы Sora 2 в 2026 году: бесплатно доступно ~5 генераций в день, с подпиской ChatGPT Plus ($20/месяц) — 30-50 видео в день, с ChatGPT Pro ($200/месяц) — до 100 видео в день.

Плюсы Sora 2 | Минусы Sora 2 |

Генерация видео по текстовому описанию — быстро и просто | Бесплатный лимит всего ~5 генераций в день |

Высокое качество роликов до 60 секунд (в 3 раза длиннее первой версии) | Требует VPN для пользователей из России |

Идеальная физика движения и встроенная генерация звука | Ролики с людьми иногда выглядят менее реалистично при сложных движениях |

Функция "Камео" для вставки себя в видео | Не подходит для задач, требующих точного контроля и покадровой анимации |

Множество встроенных инструментов: Remix, Loop, Re-cut, Storyboard | Новичкам может быть сложно разобраться в расчете «кредитов» |

Интуитивный интерфейс — не требует технических навыков | Пока не заменяет полноценный видеопродакшн |

Удобно для маркетинга, соцсетей, презентаций и креативных проектов | Ограниченные возможности по озвучке на других языках |

Быстрое время генерации — ролик готов за пару минут | Для профессиональных тарифов нужна подписка ChatGPT Pro ($200/месяц) |

Возможность редактировать и стилизовать уже созданные видео |

FAQ по Sora 2

Сколько стоит Sora 2?

Бесплатно доступно ~5 генераций в день. С подпиской ChatGPT Plus ($20/месяц) — 30-50 видео в день. Для профессионального использования нужен ChatGPT Pro ($200/месяц) с лимитом до 100 видео в день.

Как долго можно создавать видео в Sora 2?

Максимальная длина ролика — 60 секунд. Это в 3 раза больше, чем в первой версии Sora (20 секунд).

Что такое функция "Камео" в Sora 2?

Это новая функция, которая позволяет вставлять себя в сгенерированное видео. Загружаете свое фото, и нейросеть создает ролик с вашим участием.

Чтобы работать с Sora, можно использовать этот ИИ-генератор видео: пишете, что должно быть в кадре — получаете ролик прямо в браузере.

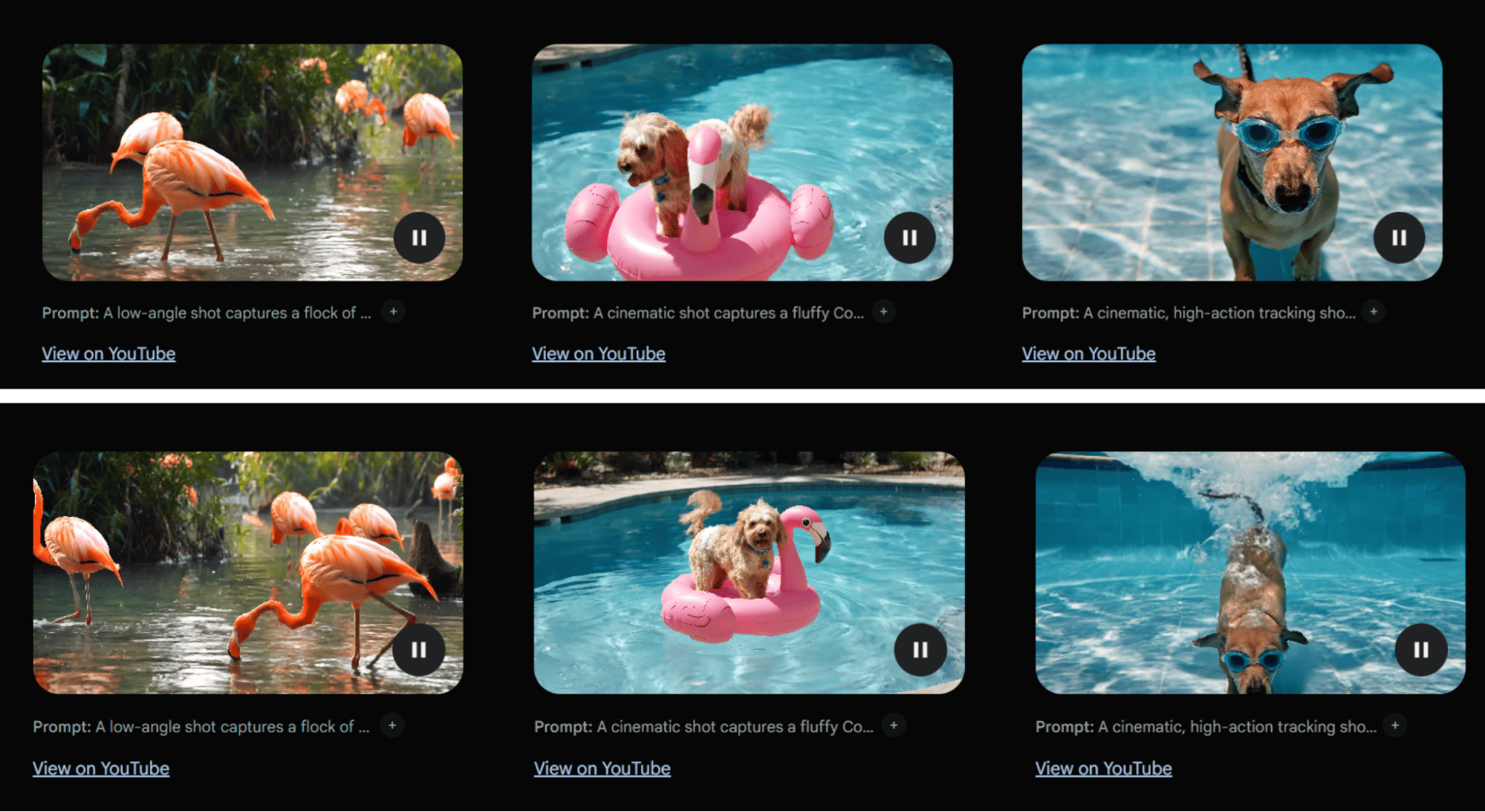

2. Google Veo 3.1 — нейросеть для создания видео в 4K качестве

Veo 3.1 — это обновленная модель генерации видео от Google, которая вышла в 2026 году. Она работает на базе ИИ и интегрирована с Google Cloud. Позволяет пользователям создавать короткие ролики до 8 секунд в 4K-качестве в разных стилях по текстовым подсказкам. Главное преимущество — возможность склеивать фрагменты в бесшовные ролики длиной до 148 секунд.

Фокус Veo 3.1 — на визуальную реалистичность, сложные эффекты, движения камеры и работу со светом. Модель генерирует видео с реалистичными голосами и озвучкой, что выгодно отличает ее от конкурентов.

У ИИ от Google есть ограничения. Например, нет AI-аватаров, то есть нельзя персонализировать ролик или использовать нужное лицо. Но нейросеть хорошо подойдет для визуально сложных коротких видео — промороликов, эстетичных заставок, mood-видео. Сработает для креативщиков и маркетологов, которым важна визуальная составляющая.

Тарифы Google Veo 3.1 в 2026 году: от $20/месяц (1000 кредитов на ~100 видео) до $250/месяц (25 000 кредитов). Доступ через Google AI Pro.

Плюсы Google Veo 3.1 | Минусы Google Veo 3.1 |

Кинематографическое качество в 4K | Нет AI-аватаров — нельзя использовать персонализированный образ |

Возможность создавать бесшовные ролики до 148 секунд | Нет инструментов для написания и редактирования сценариев |

Реалистичные голоса и встроенная озвучка | Не автоматизирует полный процесс создания ролика — от сценария до публикации |

Простота использования: ролик создается по текстовому описанию | Нет предложений от AI по доработке |

Интеграция с Google Cloud — удобно для хранения данных | Ограниченные возможности кастомизации и контроля |

Тонкая настройка света, движения камеры, ракурсов | Не обучается на прошлых данных |

Быстрое создание и скачивание | Не подходит для личного бренда или контента с «человеческим лицом» |

Хорошо подходит для маркетинговых видео и промороликов | Требует VPN для пользователей из России |

Подходит для профессионального контента |

FAQ по Google Veo 3.1

Какое максимальное качество видео в Google Veo 3.1?

Veo 3.1 генерирует видео в 4K-качестве, что является одним из лучших показателей на рынке в 2026 году. Отдельные фрагменты до 8 секунд можно склеивать в ролики до 148 секунд.

Сколько стоит Google Veo 3.1?

Тарифы начинаются от $20/месяц (1000 кредитов на ~100 видео) и доходят до $250/месяц (25 000 кредитов). Доступ через подписку Google AI Pro.

Можно ли использовать Google Veo 3.1 в России?

Сервис требует VPN для пользователей из России, так как напрямую недоступен. Платные аккаунты можно приобрести у посредников, но это требует смены IP-адреса.

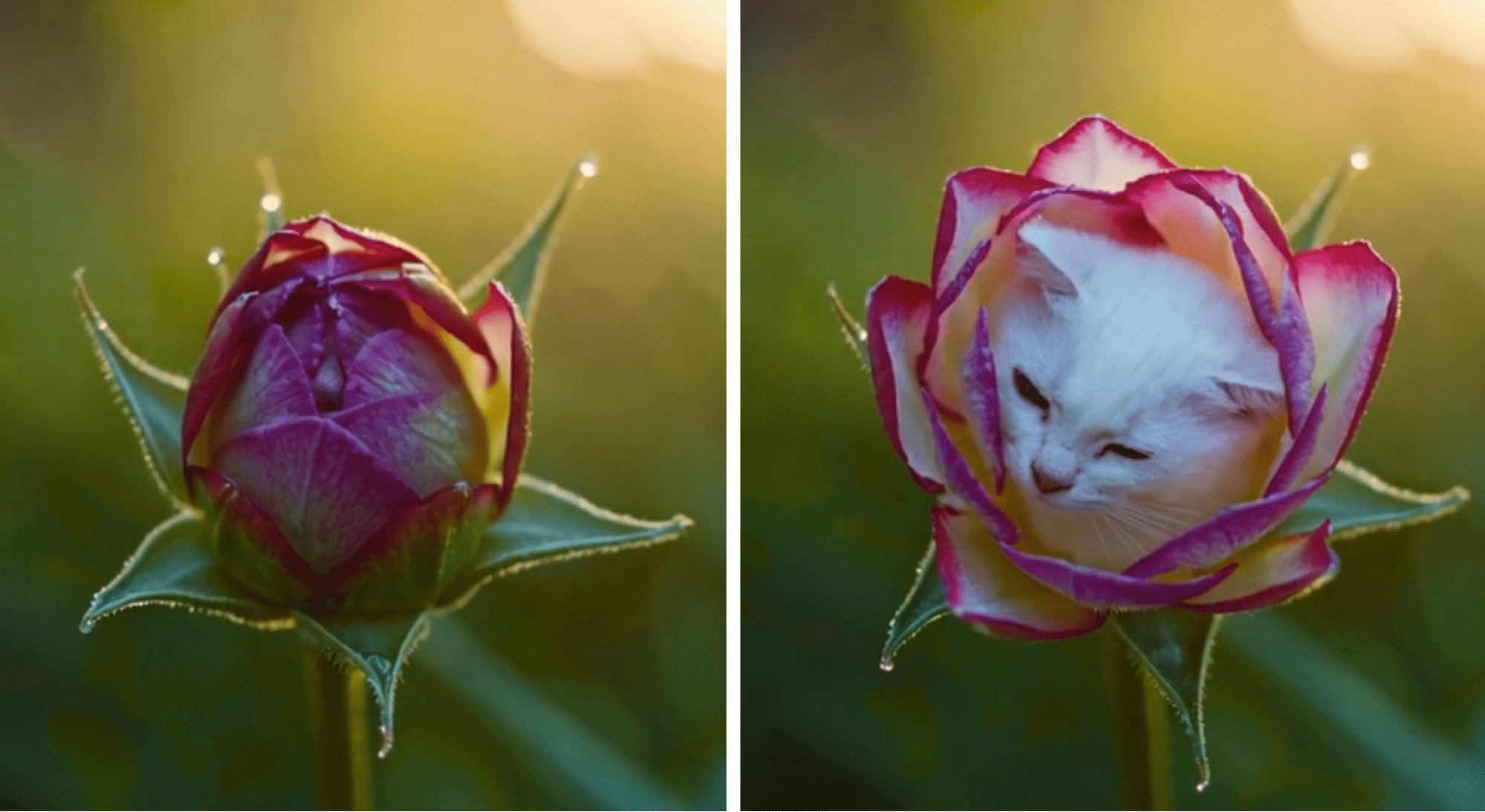

3. Vidu — нейросеть для генерации видео по картинке

Одна из фишек Vidu — создание видео по референсам. Можно загружать персонажей, объекты, окружение. Система Multi-Entity Consistency гарантирует, что все визуальные элементы будут органично сочетаться.

Загружаете изображение, описываете нужную анимацию — и получаете полноценный ролик. Эта функция идеально подходит для сторителлинга, образовательных роликов и креативов. Можно действовать и через текст — описываете, что хотите увидеть. Создание видео занимает меньше 30 секунд.

Платформа генерирует плавные движения, реалистичные переходы, масштабные эффекты и выразительную мимику. Даже лауреат премии «Оскар» продюсер Карл Рид отмечал, что Vidu справляется с 2D-анимацией.

Плюсы Vidu | Минусы Vidu |

Высокая скорость генерации (до 30 секунд) | Ограничение по длительности (до 8 секунд в бесплатном тарифе) |

Подходит как нейросеть для генерации видео по картинке | Интерфейс и функции пока доступны только online |

Работает как нейросеть для генерации ролика по описанию | Возможны артефакты при сложных сценах |

Поддержка реалистичной анимации и эффектов | Небольшой бесплатный лимит — 80 кредитов в месяц |

Семантическая точность при интерпретации запросов | Нет полноценного управления ключевыми кадрами или сценариями |

Простота интерфейса и удобство использования | |

Подходит для разных стилей: реализм и анимация | |

Возможность работы с референсами (персонажи, предметы, окружение) |

FAQ по Vidu

Как работает генерация видео по картинке в Vidu?

Загружаете изображение (персонаж, объект или окружение), описываете нужную анимацию текстом, и система создает ролик с плавными движениями. Система Multi-Entity Consistency гарантирует органичное сочетание всех элементов.

Сколько стоит Vidu?

Бесплатный тариф дает 80 кредитов в месяц, что позволяет создать несколько коротких роликов. Платные тарифы расширяют лимиты и увеличивают максимальную длительность видео.

Для каких задач лучше всего подходит Vidu?

Vidu идеально подходит для сторителлинга, образовательных роликов и креативов, где важна работа с референсами. Хорошо справляется с 2D-анимацией и реалистичными сценами.

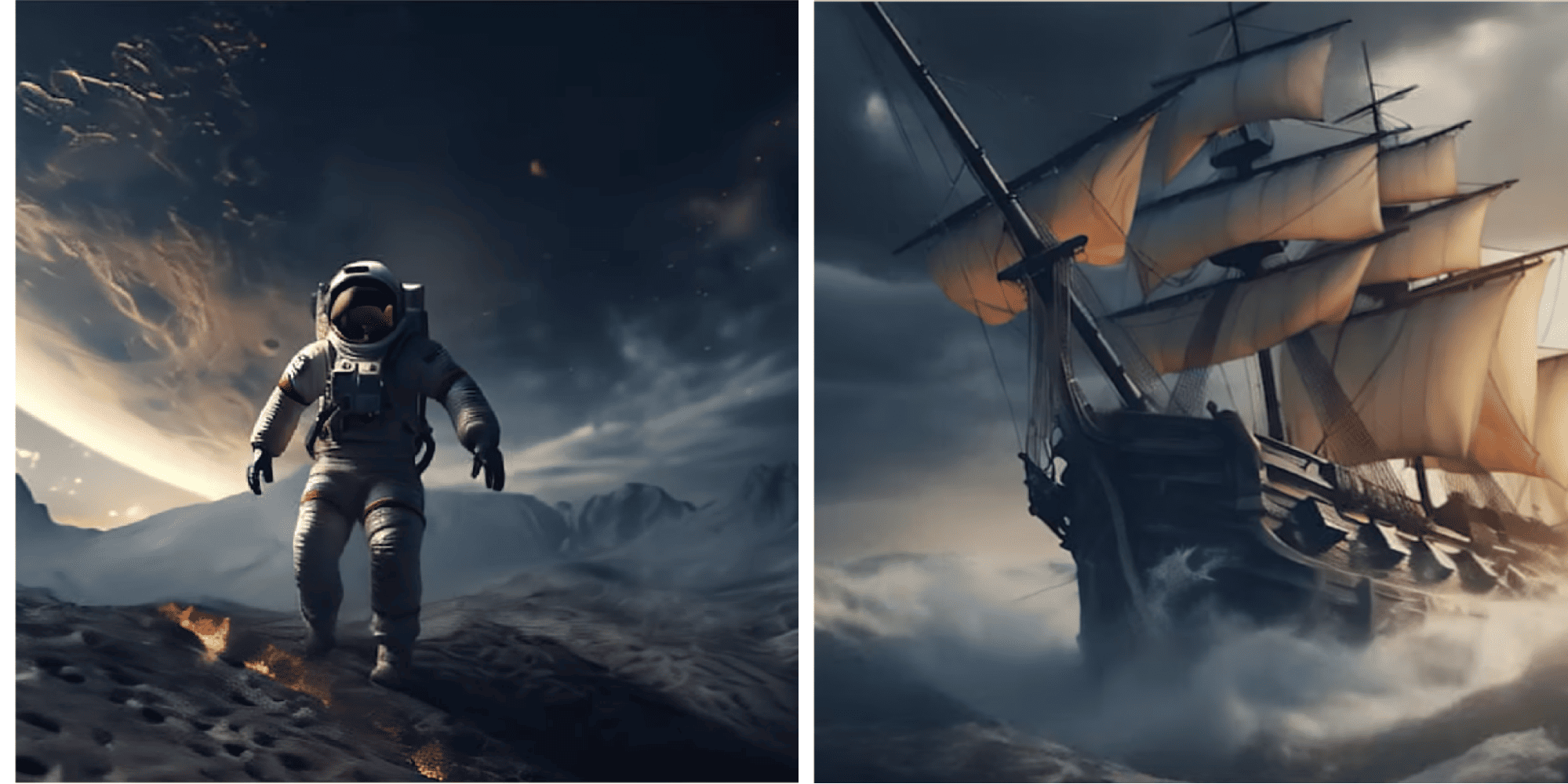

4. Runway Gen-4.5 — лучшая нейросеть для видеографов в 2026

В 2026 году Runway выпустила обновленную версию Gen-4.5, которая стала еще более мощной для профессиональных видеографов. В ИИ Runway четвертого поколения можно создать видео, будто вырезанное из sci-fi фильма. А в режиме image-to-video платформа превращает фото в атмосферный монтаж с движением, плавными переходами и киноэффектами.

Главное отличие Gen-4.5 — продвинутый контроль движения камеры и возможность обучения собственных AI-моделей. На платформе доступна расширенная кастомизация — можно управлять темпом, переходами и точными параметрами движения. Показывается превью в реальном времени — удобно следить за результатом.

Можно загрузить личные фотографии, арты, рекламные баннеры — и на выходе получить динамичный ролик с мягкими панорамами и зумами. Motion Brush стал еще точнее, позволяя контролировать движение отдельных объектов в кадре.

Тарифы Runway Gen-4.5 в 2026 году: от $15/месяц для базового тарифа с ограниченными кредитами до $200/месяц для профессиональных пользователей с неограниченным доступом к функциям.

Плюсы Runway Gen-4.5 | Минусы Runway Gen-4.5 |

Кинематографическое качество с улучшенной физикой | Возможны задержки при большой нагрузке |

Продвинутый Motion Brush для точного контроля движения | Некоторые функции требуют привыкания |

Возможность обучения собственных AI-моделей | Иногда результат не соответствует ожиданиям |

Интуитивный интерфейс | Полный доступ только в платных тарифах |

Много кастомизации и контроля | У мобильной версии урезанный функционал |

Быстрые превью в реальном времени | Требует VPN для пользователей из России |

Удобна как для новичков, так и для продвинутых пользователей |

FAQ по Runway Gen-4.5

Чем Runway Gen-4.5 отличается от Gen-3?

Gen-4.5 получил улучшенный Motion Brush для более точного контроля движения объектов, возможность обучения собственных AI-моделей и улучшенную физику движения. Это делает инструмент более подходящим для профессиональных видеографов.

Сколько стоит Runway Gen-4.5?

Тарифы начинаются от $15/месяц для базового доступа. Для профессионального использования с неограниченными кредитами и всеми функциями нужен тариф от $200/месяц.

Можно ли использовать Runway Gen-4.5 в России?

Сервис требует VPN для пользователей из России. Платные аккаунты можно приобрести у посредников, но это требует смены IP-адреса на зарубежный.

5. Stable Video Diffusion — open-source нейросеть для генерации видео

Главные отличия Stable Video Diffusion (SVD) от конкурентов — тщательная проработка стратегии обучения и масштабирование модели на огромных наборах данных. Это open-source решение, которое можно использовать локально или интегрировать в свои проекты.

ИИ умеет генерировать ролики по текстовому описанию с кинематографической проработкой сцен, превращать статичные изображения в последовательность реалистичных кадров.

Есть функция multi-view — создание нескольких согласованных ракурсов объекта. Инструмент Frame Interpolation позволяет плавно дополнять промежуточные кадры — чтобы повысить частоту видео. Используется контроль движения камеры (LoRA).

Плюсы Stable Video Diffusion | Минусы Stable Video Diffusion |

Высокое качество генерации (в том числе по тексту и изображениям) | Пока работает только с короткими роликами (несколько секунд) |

Трехступенчатое обучение с акцентом на качестве данных | Требуется мощное оборудование для локального использования |

Лучшая производительность в тестах (например, по метрике FVD на UCF-101) | Ограниченная длина и разрешение видео в открытой версии |

Поддержка разных генеративных форматов: text-to-video, image-to-video, multi-view | Пока отсутствует удобный пользовательский интерфейс (все через код) |

Фрейм-интерполяция и контроль движения камеры (LoRA) | Не всегда стабильно работает с персонажами, сложными сценами и лицами |

Открытый код и доступ к весам модели | Отсутствие встроенной постобработки (например, озвучка, субтитры, монтаж) |

Подходит для исследований, анимации, концепт-арта, маркетинга и сторителлинга | Для обучения и доработки требует технической подготовки |

FAQ по Stable Video Diffusion

Можно ли использовать Stable Video Diffusion бесплатно?

Да, это open-source решение с открытым кодом. Вы можете использовать его бесплатно, но для локального запуска потребуется мощное оборудование (GPU с достаточным объемом памяти).

Для кого подходит Stable Video Diffusion?

Инструмент идеально подходит для разработчиков, исследователей и тех, кто хочет интегрировать генерацию видео в свои проекты. Требует технической подготовки для настройки и использования.

Какие форматы генерации поддерживает SVD?

Stable Video Diffusion поддерживает text-to-video (генерация по тексту), image-to-video (преобразование изображений в видео) и multi-view (создание нескольких ракурсов объекта).

Подпишитесь на нашу рассылку — раз в неделю будем отправлять на ваш email свежую статью из блога и другие полезные материалы.

💌 Еженедельная рассылка

6. Hailuo — нейросеть для генерации видео с точным контролем камеры

Нейросеть Hailuo AI MiniMax позволяет генерировать полноценные креативы на основе одного изображения.

Hailuo хорошо создает сцены, в которых требуется плавное, минималистичное движение. Например, медленный зум. Сложнее обстоят дела с быстрыми сценами: активным движением персонажей, резкой сменой ракурсов. Такие видео иногда требуют нескольких итераций и шлифовки промпта.

Сложные действия — бег, танец — могут давать нестабильный результат. Но если использовать четкий и детализированный запрос, ИИ способен справиться и с этим.

Плюсы Hailuo AI MiniMax | Минусы Hailuo AI MiniMax |

Точный контроль над композицией, движением камеры и стилем | Требует очень точных и детальных промптов для хорошего результата |

Поддержка сложных киношных приемов: панорам, зумов, смены планов | Возможны артефакты или некорректные движения при попытке передать экшен |

Удобная работа с изображением как точкой отсчета | Несоответствие между загруженной картинкой и промптом снижает качество |

Подходит для постановочных и художественных сцен | Может потребоваться несколько итераций для желаемого результата |

Совместим с профессиональной режиссурой и сторителлингом | Отсутствуют встроенные инструменты озвучки или автоматического монтажа |

Хорошо интерпретирует движения камеры и атмосферу сцены | Пока не оптимизирован для мобильного использования |

Баланс между визуальным качеством и гибкостью | Меньшая стабильность при сложной анимации (например, бег или танец) |

FAQ по Hailuo

Для каких задач лучше всего подходит Hailuo?

Hailuo идеально подходит для постановочных и художественных сцен с плавным движением камеры. Хорошо работает с медленными зумами, панорамами и сменой планов. Сложные экшен-сцены могут потребовать нескольких итераций.

Нужны ли специальные навыки для работы с Hailuo?

Инструмент требует точных и детальных промптов для хорошего результата. Чем конкретнее вы опишете движение камеры и композицию, тем лучше будет результат.

Можно ли использовать Hailuo для быстрых экшен-сцен?

Сложные действия (бег, танец) могут давать нестабильный результат. Для таких задач лучше использовать другие инструменты или делать несколько итераций с уточнением промпта.

7. Kling AI — нейросеть для фотореалистичных видео с людьми

ИИ Kling AI в 2026 году стал одним из лидеров по созданию фотореалистичных видео с людьми. Хорошо справляется с простыми сценами и плавными действиями, особенно с естественными движениями людей — ходьбой, паузами, мимикой. Как и большинство генераторов, сложно работает с быстрыми и сложными движениями вроде танцев или прыжков.

Motion Brush — одна из самых интересных фишек этого ИИ. С ее помощью можно вручную задать траекторию движения объектов в кадре через рисунок прямо по изображению. Motion Brush отлично справляется с мелкими движениями, например, поворотами головы. При этом Kling может добиться похожего эффекта через промпт, но без такой точности.

В 2026 году Kling AI интегрировался с DeepSeek для оптимизации промптов, что упрощает создание качественных видео. Генерация занимает меньше минуты, что делает инструмент одним из самых быстрых на рынке.

Тарифы Kling AI в 2026 году: от $10/месяц для базового тарифа с ограниченными кредитами. Есть бесплатный тариф с минимальными лимитами для тестирования.

Плюсы Kling AI | Минусы Kling AI |

Лучшая нейросеть для фотореалистичных видео с людьми | Менее стабильное соответствие текстовому промту по сравнению с Hailuo |

Естественные движения людей: ходьба, паузы, мимика | Сложно работает с быстрым действием (например, бег, танец, экшен-сцены) |

Поддержка text-to-video и image-to-video | В сложных сценах может потребоваться доработка и повторный запрос |

Интеграция с DeepSeek для оптимизации промптов | Иногда ролик получается с избыточным контрастом |

Возможность точной анимации второстепенных элементов через Motion Brush | Пока уступает Runway Gen-4.5 по кинематографичности |

Быстрая генерация — меньше минуты | |

Активное развитие платформы, регулярные обновления | |

Доступен в России без VPN |

FAQ по Kling AI

Почему Kling AI лучше других для видео с людьми?

Kling AI специализируется на создании фотореалистичных видео с естественными движениями людей. Хорошо передает ходьбу, паузы, мимику и другие естественные движения, что делает его лучшим выбором для контента с людьми.

Сколько стоит Kling AI?

Тарифы начинаются от $10/месяц для базового доступа. Есть бесплатный тариф с минимальными лимитами для тестирования функционала.

Можно ли использовать Kling AI в России?

Да, Kling AI доступен в России без VPN, что делает его удобным выбором для российских пользователей.

8. Luma Dream Machine 1.6 — нейросеть для генерации видео и 3D-моделей

Luma Dream Machine 1.6 — это обновленная версия популярной нейросети от Luma AI, которая вышла в 2026 году. Главное отличие от конкурентов — поддержка генерации 3D-моделей с использованием технологии NeRF (Neural Radiance Fields) в дополнение к созданию видео.

Dream Machine 1.6 поддерживает создание видео длиной до 5 секунд (120 кадров) из текста или изображений. Модель генерирует синхронизированный звук и визуальные эффекты, что делает ролики более живыми и атмосферными.

В декабре 2025 года Luma AI анонсировала новую модель Ray3 Modify, которая позволяет редактировать и переделывать видео с точными элементами управления ключевыми кадрами и ссылками на персонажей. Это гибридный AI-инструмент для работы с актёрской игрой и производством.

Dream Machine 1.6 особенно хороша для создания коротких креативов, рекламных роликов и контента для соцсетей. Поддержка 3D-моделей открывает новые возможности для разработчиков и дизайнеров.

Плюсы Luma Dream Machine 1.6 | Минусы Luma Dream Machine 1.6 |

Генерация видео до 5 секунд (120 кадров) | Ограничение по длительности — только 5 секунд |

Поддержка генерации 3D-моделей (NeRF) | Меньше возможностей по сравнению с Sora 2 или Veo 3.1 |

Синхронизированный звук и визуальные эффекты | Требует VPN для пользователей из России |

Поддержка text-to-video и image-to-video | Ограниченные возможности кастомизации |

Ray3 Modify для редактирования видео с контролем ключевых кадров | Пока не подходит для длинных роликов |

Хорошо подходит для коротких креативов и соцсетей | |

Интуитивный интерфейс |

FAQ по Luma Dream Machine 1.6

Чем Dream Machine 1.6 отличается от других нейросетей?

Главное отличие — поддержка генерации 3D-моделей с использованием технологии NeRF в дополнение к созданию видео. Это открывает новые возможности для разработчиков и дизайнеров.

Какую максимальную длину видео можно создать?

Dream Machine 1.6 создает видео длиной до 5 секунд (120 кадров). Это меньше, чем у лидеров рынка, но достаточно для коротких креативов и контента для соцсетей.

Что такое Ray3 Modify?

Ray3 Modify — новая модель от Luma AI, которая позволяет редактировать и переделывать видео с точным контролем ключевых кадров и ссылками на персонажей. Это гибридный инструмент для профессиональной работы с видео.

9. Wan AI — нейросеть для качественной генерации лиц и кинематографичных сцен

Wan AI от Alibaba — это специализированная нейросеть для создания видео с качественной генерацией лиц и кинематографичных сцен. В 2026 году модель стала одним из лидеров по реалистичности передачи человеческих лиц и выражений.

Wan AI позволяет создавать видео длиной до 6 секунд в бесплатном тарифе и до 15 секунд в платном. Особенность — поддержка озвучки собственным голосом и функция оживления картинок, что делает инструмент уникальным для создания персонализированного контента.

Нейросеть хорошо справляется с кинематографичными сценами, портретами и видео с людьми. Качество генерации лиц превосходит многие западные аналоги, что делает Wan AI популярным выбором для азиатского рынка и пользователей, которым важна реалистичность человеческих образов.

Wan AI доступен в России без VPN, что является дополнительным преимуществом для российских пользователей. Тарифы варьируются от бесплатного (до 6 секунд) до платных с расширенными возможностями.

Плюсы Wan AI | Минусы Wan AI |

Лучшая генерация лиц среди конкурентов | Ограничение по длительности (до 6-15 секунд) |

Кинематографичное качество сцен | Меньше функций по сравнению с Sora 2 или Veo 3.1 |

Озвучка собственным голосом | Интерфейс может быть сложным для новичков |

Функция оживления картинок | Ограниченные возможности для длинных роликов |

Доступен в России без VPN | |

Хорошо подходит для портретов и видео с людьми | |

Реалистичная передача выражений лица |

FAQ по Wan AI

Почему Wan AI лучше других для генерации лиц?

Wan AI специализируется на качественной генерации человеческих лиц и выражений. Модель обучена на больших датасетах с акцентом на реалистичность портретов, что делает ее лучшим выбором для контента с людьми.

Можно ли использовать Wan AI в России?

Да, Wan AI доступен в России без VPN, что является значительным преимуществом по сравнению с западными сервисами, которые требуют VPN.

Какие функции есть в Wan AI?

Помимо генерации видео, Wan AI поддерживает озвучку собственным голосом и функцию оживления картинок. Это позволяет создавать персонализированный контент с вашим участием.

10. Genmo Mochi — open-source нейросеть с реалистичной физикой

ИИ от Genmo четко следует текстовому сценарию: учитывает персонажей, окружение, ракурсы, стиль камеры и настроение сцены. Дополняет это реалистичная симуляция физики — ветер, волосы, вода, ткань, мимика. То есть с Mochi можно создавать короткие сцены с живыми персонажами и детализированным окружением.

Mochi дает «управлять камерой»: прописывать панораму, зум, наклон и поворот, плавные переходы. Уровень динамики можно настроить от стабильного (50%) до максимально насыщенного движением (99%).

Главное преимущество Genmo Mochi — открытый исходный код (Apache 2.0), что позволяет разработчикам дорабатывать модель и интегрировать ее в свои проекты. Это делает инструмент популярным среди исследователей и разработчиков.

Плюсы Genmo Mochi | Минусы Genmo Mochi |

Хорошо работает как нейросеть для генерации видео по тексту | Видео пока только в качестве 480p (ожидается HD-обновление) |

Реалистичная физика движения, тканей, жидкости и окружающей среды | При сложных сценах возможны артефакты и искажения |

Расширенное управление движением камеры | Модель больше заточена под фотореализм, чем под стилизацию или мультфильмы |

Открытый исходный код (Apache 2.0) — можно дорабатывать, внедрять в проекты | |

Удобна для разработчиков и исследователей, которые хотят настроить сервис под себя |

FAQ по Genmo Mochi

Можно ли использовать Genmo Mochi бесплатно?

Да, Genmo Mochi имеет открытый исходный код (Apache 2.0), что позволяет использовать его бесплатно. Вы можете дорабатывать модель и интегрировать ее в свои проекты.

Для кого подходит Genmo Mochi?

Инструмент идеально подходит для разработчиков и исследователей, которые хотят настроить модель под свои задачи. Реалистичная физика делает его хорошим выбором для создания сцен с естественными движениями.

Какое качество видео в Genmo Mochi?

Пока видео генерируется только в качестве 480p. Разработчики обещают HD-обновление в будущем.

11. Kandinsky 4.0 — русская бесплатная нейросеть для видео

Kandinsky 4.0 — логическое продолжение моделей Kandinsky 3.0/3.1 (text-to-image) и Kandinsky Video 1.0/1.1 (text-to-video). У «Кандинского» частично открытый код и бесплатный API-доступ.

Что умеет русская бесплатная нейросеть для видео?

Text-to-Video: генерирует ролик по текстовому описанию.

Image-to-Video: превращает изображения в видео с моушеном и переходами.

Text-to-Image-to-Video: по тексту создает картинку, а затем ролик.

Video-to-Audio: генерирует аудио сопровождение к видео.

Модель поддерживает реалистичные эффекты — свет, ветер, движение жидкости, блики. Можно прописать детали: мягкий фокус, кинематографическая глубина резкости. На практике, чтобы получить хороший результат, нужно несколько попыток. На каждую уходит примерно по 4 минуты.

Плюсы Kandinsky 4.0 | Минусы Kandinsky 4.0 |

Создание реалистичных и динамичных роликов | Возможны артефакты при сложных переходах между ключевыми кадрами |

Поддержка текста, изображений, смешанных режимов | Иногда сложно интерпретирует абстрактные или философские концепты |

Быстрая работа (до 11 секунд на видео) | Требует значительных вычислительных ресурсов для HD-выхода |

Открытая и доступная модель, API | Качество ограничено 480p (ожидается HD-обновление) |

Эффективная архитектура с продуманными последовательностями этапов | Могут быть ограничения в передаче сложных временных связей между сценами |

Возможность создать аудиодорожку к ролику | Не всегда справляется с очень высокой детализацией |

Подписывайтесь на наш ВК и Телеграм, чтобы узнавать последние новости SEO и подсматривать новые фишки продвижения.

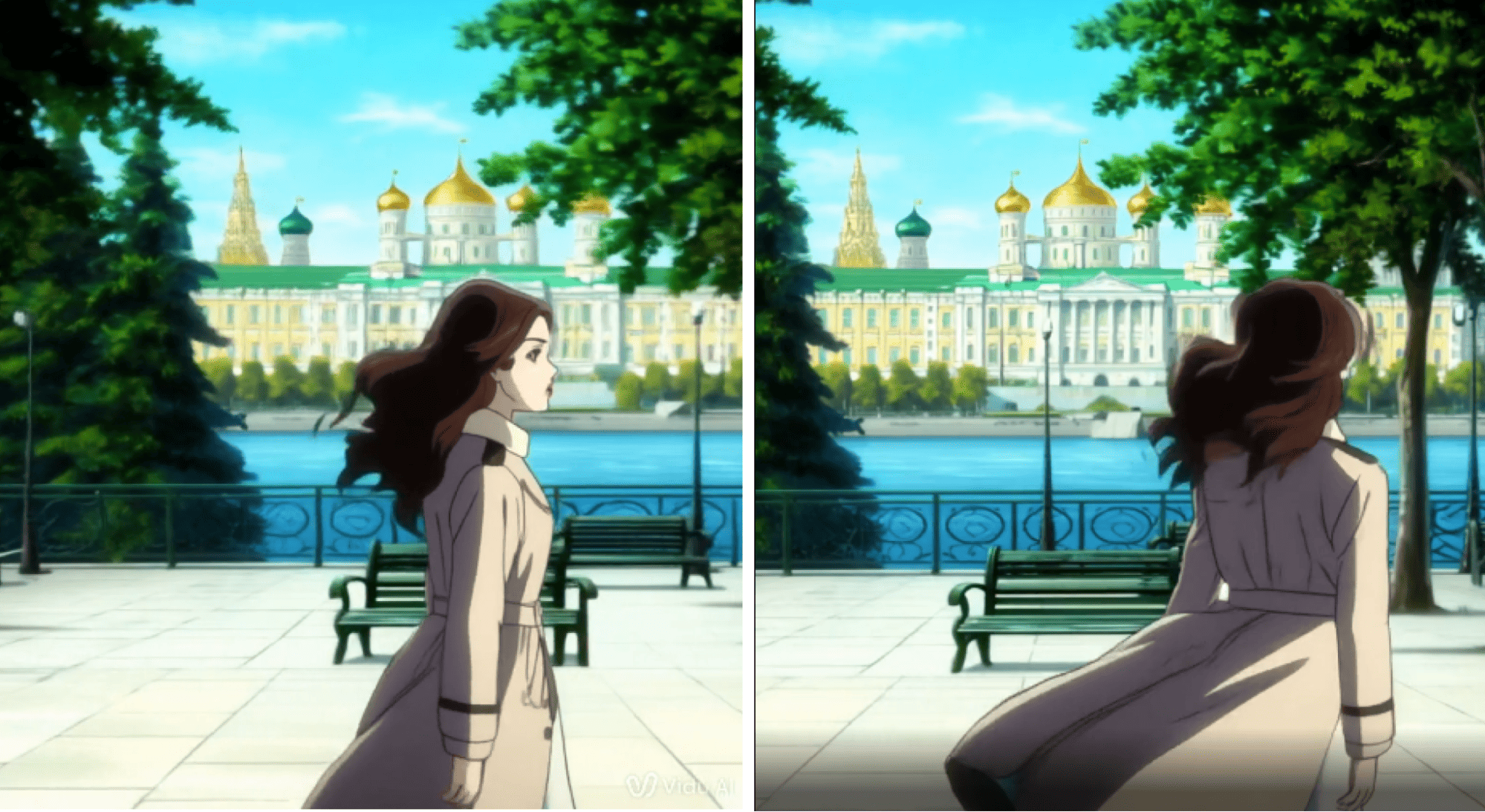

12. Шедеврум — нейросеть для генерации видео от Яндекса

ИИ Шедеврум от Яндекса может генерировать четырехсекундные ролики с частотой 24 кадра в секунду в формате MP4. Чтобы получить ролик, пользователю нужно ввести текстовое описание задуманной сцены. Далее ИИ предложит четыре варианта первого кадра и набор анимационных эффектов, которые определяют стиль движения в ролике.

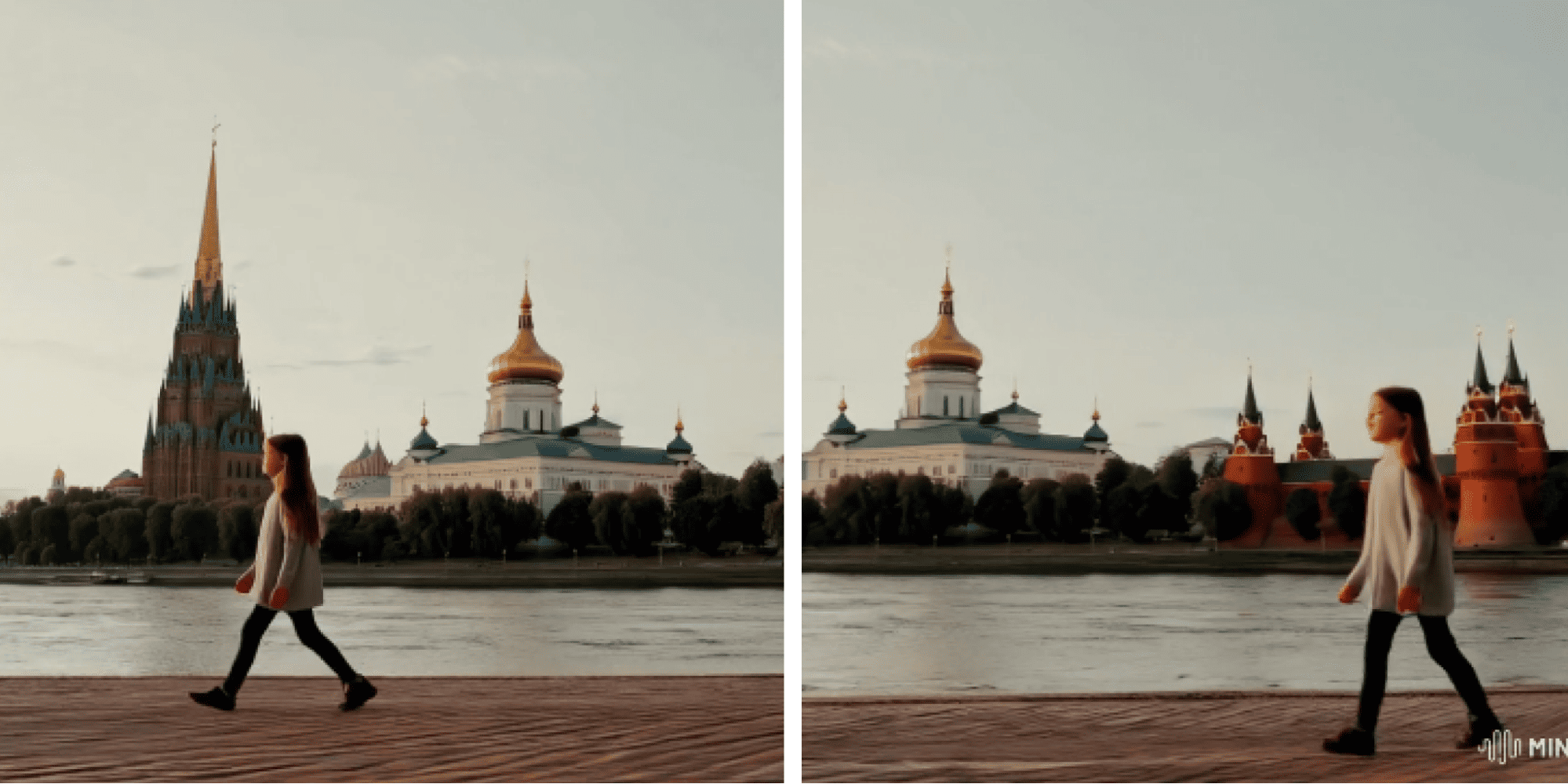

На практике Шедеврум иногда отказывается выполнять запросы. Например, не хочет генерировать видео по промпту «Девушка гуляет по набережной Москвы, на фоне Кремль, естественное освещение». Но соглашается на запрос «Девушка гуляет по набережной Москвы».

Первые кадры — изображения — получаются отличные, но при анимации ИИ иногда сливает человека с объектами, а сама картинка немного дергается. В 2026 году модель все еще находится в тестовом режиме и доступна не всем пользователям.

Плюсы Шедеврума | Минусы Шедеврума |

Простота использования: генерация ролика по текстовому описанию | Ограничение по длине — всего 4 секунды |

Несколько анимационных эффектов на выбор (7 вариантов) | Пока работает только в тестовом режиме и доступна не всем |

Интуитивный интерфейс и быстрый результат | Нет гибкой настройки движения или кадра (в отличие от профессиональных инструментов) |

Возможность выбрать один из четырех начальных кадров | Пока подходит только для простых визуальных задач |

Поддержка MP4 и стандартная частота кадров (24 fps) | Иногда отказывается выполнять сложные запросы |

Интеграция с другими функциями приложения (изображения, тексты) | При анимации возможны артефакты и дергание картинки |

Быстрый экспорт и возможность публикации | |

Доступен в России без VPN |

FAQ по Шедевруму

Можно ли использовать Шедеврум бесплатно?

Да, Шедеврум доступен бесплатно, но пока работает в тестовом режиме и доступен не всем пользователям. Модель интегрирована в приложение Яндекса.

Какая максимальная длина видео в Шедевруме?

Максимальная длина ролика — 4 секунды с частотой 24 кадра в секунду. Это меньше, чем у большинства конкурентов, но достаточно для коротких креативов.

Почему Шедеврум иногда отказывается выполнять запросы?

Модель может отказываться выполнять сложные или слишком детализированные запросы. Рекомендуется упрощать промпты и разбивать сложные сцены на более простые элементы.

Как правильно составлять промпты для генерации видео: инструкция

Несмотря на разницу в интерфейсах и технических возможностях ИИ, принципы построения промта универсальны для них всех. В 2026 году модели стали лучше понимать контекст, но правильная формулировка все еще критически важна для получения качественного результата:

Главный объект или действие. Это может быть персонаж, животное, природное явление, техника или фантастическая сущность. Чем конкретнее, тем лучше. Пример: «Робот идет по разрушенному городу».

Сцена и окружение. Опишите, где происходит действие: пейзаж, интерьер, время суток, погодные условия. Пример: «Город в постапокалиптическом стиле, сумерки, туман».

Движение или динамика. Видео предполагает развитие — добавьте глаголы и пространственные указания: «летит», «движется вперед», «камера вращается», «вид сверху». Пример: «Дрон пролетает над каньоном».

Стиль и атмосфера. Уточните художественную обработку: реализм, мультфильм, неон, стимпанк, 3D, черно-белое кино. Пример: «В стилистике научной фантастики 70-х годов».

Темп и ритм. Если ИИ это поддерживает, полезно указать, какое движение вам нужно: быстрое, медленное, плавное или скачкообразное.

Технические параметры (для продвинутых моделей). Укажите движение камеры (панорама, зум, трекинг), освещение (естественное, студийное, неоновое), ракурс (крупный план, общий план, вид сверху).

FAQ по составлению промптов для генерации видео

Какой длины должен быть промпт для генерации видео?

Оптимальная длина — 20-50 слов. Слишком короткие промпты дают общий результат, слишком длинные могут сбить алгоритм. Лучше быть конкретным и структурированным: объект + действие + окружение + стиль.

Нужно ли указывать технические параметры камеры в промпте?

Да, если модель это поддерживает (например, Runway Gen-4.5, Hailuo). Указание движения камеры, освещения и ракурса значительно улучшает результат. Используйте термины: "панорама влево", "медленный зум", "трекинг-план", "естественное освещение".

Можно ли использовать промпты на русском языке?

Большинство западных моделей (Sora 2, Veo 3.1, Runway) лучше работают с английскими промптами. Российские нейросети (Kandinsky, Шедеврум) отлично понимают русский язык. Для лучшего результата используйте английский для западных моделей или переводите промпт перед использованием.

Частые ошибки при составлении промптов для генерации роликов

Избыточная длина запроса. Слишком длинные промты затрудняют интерпретацию. Лучше — коротко и по сути. Оптимально — 20-50 слов с четкой структурой.

Слишком общие фразы. Например, «что-то красивое» или «вдохновляющее видео». Они не дадут ИИ нужных ориентиров. Вместо абстракций используйте конкретные визуальные образы: "закат над океаном, золотые облака, спокойная вода".

Противоречия в запросе. Не упоминайте в промпте одновременно день и ночь, джунгли и пустыню, реализм и мультяшность. Это сбивает алгоритм и приводит к некачественному результату.

Игнорирование технических параметров. Многие модели поддерживают указание движения камеры, освещения и ракурса. Не указывая эти параметры, вы упускаете возможность получить более качественный результат.

Использование неподходящего языка. Западные модели лучше работают с английскими промптами. Использование русского может снизить качество результата.

FAQ по ошибкам в промптах

Почему нейросеть не понимает мой промпт?

Чаще всего проблема в слишком общих формулировках или противоречиях. Конкретизируйте запрос: вместо "красивое видео" напишите "закат над океаном, золотые облака, спокойная вода, камера медленно движется вперед". Убедитесь, что нет противоречий (день/ночь, реализм/мультфильм).

Сколько раз можно переделывать промпт?

Ограничений нет, но каждая генерация расходует кредиты (в платных тарифах) или лимиты (в бесплатных). Лучше сначала продумать промпт, используя структуру: объект + действие + окружение + стиль + технические параметры.

Можно ли комбинировать несколько идей в одном промпте?

Да, но осторожно. Лучше создавать отдельные ролики для разных сцен, а затем склеивать их. Смешивание слишком разных идей в одном промпте может привести к некачественному результату.

Сравнение нейросетей для генерации видео в 2026 году

В 2026 году рынок нейросетей для генерации видео значительно вырос. Ниже представлена актуальная таблица сравнения лучших инструментов с учетом обновлений и новых возможностей.

Название | Главное преимущество | Ограничения | Цена (2026) | Особенности |

Sora 2 | Ролики до 60 сек, функция "Камео", идеальная физика | Бесплатно только ~5 генераций/день, требует VPN в России | Бесплатно / $20-200/мес | Remix, Re-cut, Loop, Storyboard, встроенный звук |

Google Veo 3.1 | 4K-качество, ролики до 148 сек при склеивании | Нет аватаров, требует VPN в России | $20-250/мес | Реалистичные голоса, интеграция с Google Cloud |

Runway Gen-4.5 | Продвинутый Motion Brush, обучение собственных моделей | Требует VPN в России, полный доступ только платно | $15-200/мес | Максимальный контроль для видеографов |

Kling AI | Лучшая генерация видео с людьми, естественные движения | Не справляется с быстрым экшеном | $10/мес | Интеграция с DeepSeek, доступен в России |

Luma Dream Machine 1.6 | Генерация 3D-моделей (NeRF), синхронизированный звук | Только 5 секунд, требует VPN в России | От $10/мес | Ray3 Modify для редактирования, поддержка 3D |

Wan AI | Лучшая генерация лиц, кинематографичные сцены | До 6-15 секунд, меньше функций | Бесплатно / платно | Озвучка своим голосом, доступен в России |

Vidu | Работа с референсами, высокая семантическая точность | Ролики только до 8 сек, небольшой лимит бесплатных кредитов | Бесплатно / платно | Поддержка текста и изображений, Multi-Entity Consistency |

Hailuo | Точный контроль движения камеры, постановочные сцены | Требует точных промптов, не справляется с экшеном | Платно | Подходит для медленных, художественных сцен |

Stable Video Diffusion | Open-source, фрейм-интерполяция, multi-view | Сложность настройки, короткие видео, слабый UI | Бесплатно (open-source) | Высокое качество, LoRA для движения камеры |

Genmo Mochi | Open-source, реалистичная физика, управление камерой | Качество только 480p, слабая стилизация | Бесплатно (open-source) | Управление динамикой (50-99%), Apache 2.0 |

Kandinsky 4.0 | Мультирежимность: текст, изображение, звук, бесплатный API | Качество только 480p, требует вычислительных ресурсов | Бесплатно | Доступен в России, быстрая генерация, API |

Шедеврум | Простота использования, 7 стилей движения | Длительность только до 4 сек, тестовый режим | Бесплатно | Выбор из 4 стартовых кадров, доступен в России |

FAQ по выбору нейросети для генерации видео

Какую нейросеть выбрать для начала работы?

Для новичков лучше начать с бесплатных вариантов: Sora 2 (если есть доступ) или Kandinsky 4.0 (доступен в России). Для профессиональной работы с людьми — Kling AI ($10/мес). Для максимального качества — Google Veo 3.1 или Sora 2 с подпиской.

Какая нейросеть лучше для российских пользователей?

Доступны без VPN: Kling AI, Wan AI, Kandinsky 4.0, Шедеврум. Для западных сервисов (Sora 2, Veo 3.1, Runway) потребуется VPN и зарубежный IP-адрес.

Можно ли использовать несколько нейросетей одновременно?

Да, многие профессионалы используют разные инструменты для разных задач: Sora 2 для общих сцен, Kling AI для видео с людьми, Runway Gen-4.5 для профессионального контроля. Это позволяет получить максимум от каждой модели.