Ждать и надеяться, что Google сперва просканирует, а после проиндексирует абсолютно все страницы веб-ресурса, не нужно. Это может никогда не случиться, даже если страницы сайта с технической стороны выглядят нормально.

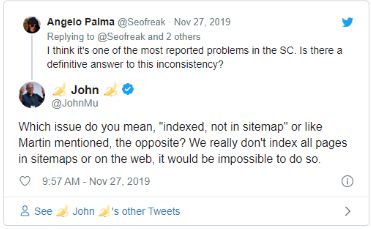

Вывод следует из диалога с Джоном Мюллером. Последнему поступила жалоба от сеошника, который упрекнул поисковую машину в упорном нежелании индексировать все страницы, которые присутствуют в файле Sitemap.xml.

Отвечая, Гуглмен выразил уверенность, что это вполне обычная ситуация – тотальной индексации не может быть в принципе:

«На самом деле мы не индексируем все страницы из Карты сайта или которые есть в интернете. На практике это невозможно сделать».

Иначе говоря, поисковик даже не ставит перед собой цель внести в свой индекс весь контент, который есть в сети. Возникает вопрос – каковы в таком случае критерии отбора URL-адресов для включения в Google SERP? Перед какими страницами загорается зеленый свет, а каким доступ в выдачу заказан?

Поделитесь своими мыслями на этот счет в комментариях. Будем признательны!