Содержание

Краткое саммари

В статье рассказываем:

- что именно делает BERT,

- как связаны BERT и RankBrain,

- почему ModernBERT важен как ориентир для NLP,

- что менять в контенте, чтобы улучшать позиции и CTR.

Кому стоит прочитать статью:

- SEO‑специалистам, которые продвигают контент под Google и хотят понимать, что стоит за нейросетевым поиском.

- Редакторам и копирайтерам, которые пишут статьи под интент и сниппеты.

- Владельцам сайтов, которым важны CTR и стабильный органический трафик.

Раньше поисковые системы и нейросети понимали текст довольно примитивно — они искали отдельные слова, не учитывая контекст. Это приводило к неточным результатам, когда алгоритмы путали значения слов и выдавали нерелевантные ответы. В 2018 году Google представил BERT, и это стало прорывом в обработке естественного языка (NLP).

Что такое BERT

BERT — это открытый фреймворк машинного обучения для обработки естественного языка. Его задача — помочь компьютерам понимать смысл неоднозначных выражений, используя контекст.

Алгоритм BERT (или Bidirectional Encoder Representations from Transformers) основан на трансформерах — модели глубокого обучения, в которой каждый элемент вывода связан с каждым элементом ввода. Они динамически рассчитываются по взаимосвязи.

Прежние языковые модели обрабатывали текст только в одном направлении — либо слева направо, либо справа налево. «Берт» же способен анализировать текст в обоих направлениях одновременно.

«Берт» повлиял на дальнейшее развитие ИИ. Его методы обучения использовались в моделях GPT-2, ChatGPT и других современных языковых моделях.

Этапы развития алгоритма BERT

2018 год — Google представил BERT и выложил его в открытый доступ. На стадии исследований модель показала выдающиеся результаты в анализе тональности, классификации текстов и определении многозначных слов.

Октябрь 2019 — Google объявил о внедрении технологии в поисковые алгоритмы в США. Понимание поисковых запросов выросло примерно на 10%.

Декабрь 2019 — BERT распространили более чем на 70 языков. Это повлияло на голосовой поиск и повысило точность выдачи поисковых систем.

BERT в 2026 году: ModernBERT

В конце 2024 года Google представил улучшенную версию алгоритма — ModernBERT. Она поддерживает более длинные тексты размером до 8192 токенов. Это значит, что инструмент стал лучше понимать контекст в статьях, документах и книгах, а не только в коротких фразах.

У ModernBERT новая система понимания порядка слов (Rotary Positional Encoding, или RoPE). Обычным нейросетям добавляют специальные метки, которые указывают, какое слово стоит раньше, а какое позже. Система понимания порядка слов более гибко определяет позиции между токенами.

Еще одно новшество — удаление заполнений. Раньше когда модель анализировала несколько текстов одновременно, более короткие из них дополнялись пустыми заполнителями. Это делалось, чтобы все тексты получились одной длины: иначе параллельное вычисление было невозможно. ModernBERT научился обходить ограничение и теперь не тратит время и ресурсы на обработку ненужных символов.

Раньше модель либо смотрела на весь текст сразу, либо только на ближайшие слова. Сейчас она сначала анализирует ближайший контекст (локальное внимание), а потом учитывает весь текст (глобальное внимание). Это помогает лучше понимать смысл предложений и ускоряет работу.

Модель обучили на огромном массиве текстов — не только на статьях и книгах, но и на программном коде, научных работах и веб-документах. Поиск стал точнее и глубже.

Влияние алгоритма BERT на результаты поиска

Модель изменила подход к поисковой оптимизации. Раньше Google искал точные соответствия ключевых слов. BERT же позволил поиску лучше интерпретировать смысл запросов.

Теперь SEO-специалистам нужно смещать фокус с ключевых слов на тематику и намерение пользователя. С этим тесно связано удобство сайта и логичность структуры. Чем полезнее контент для пользователя, тем выше позиции сайта в поиске.

BERT улучшил понимание длинных разговорных запросов, которые точнее отражают потребности пользователя. Поэтому ключевые слова с длинным хвостом стали более значимыми для SEO.

Качество контента стало важнее плотности ключей. Раньше сайты могли продвигаться за счет перенасыщения текста популярными запросами. «Берт» изменил приоритеты — предпочтение система отдает глубокому и полезному контенту, который полностью отвечает на запрос пользователя.

BERT помог Google точнее формировать расширенный сниппет (featured snippets), который используется в обычном поиске и в голосовых ассистентах. Это значит, что специалистам нужно оптимизировать страницы под голосовые запросы, которые обычно начинаются с вопроса — например, «как», «почему», «что такое».

Модель BERT лучше понимает синонимы и связанные понятия, это позволяет поисковику выдавать более релевантные результаты. SEO-стратегии теперь должны включать семантические вариации ключевых слов и учитывать смежные темы.

Как оптимизировать сайт под алгоритм BERT: 5 практических советов

1. «Берт» анализирует контекст запроса, поэтому важно, чтобы страница давала полноценный ответ на вопрос пользователя.

Как это использовать? Изучите вопросы и потребности аудитории, пишите развернутые и полезные статьи. Добавляйте естественные фразы, близкие к тому, как люди формулируют запросы. Избегайте переспама.

Пример. Вместо «Лучшие кроссовки для бега купить недорого» нужно писать «Как выбрать удобные кроссовки для бега и на что обратить внимание».

2. BERT хорошо понимает живой, разговорный язык. Чем проще и понятнее текст, тем выше вероятность, что Google его правильно интерпретирует.

Как это использовать? Откажитесь от сложных формулировок — нужны простые слова и короткие предложения. Избегайте сложных терминов и канцелярита. Используйте синонимы и естественные вариации ключевых фраз.

Пример. Вместо «При подборе обуви для спортивных занятий и тренировок важно учитывать супинацию и пронацию стопы» нужно писать «При выборе кроссовок важно учитывать, как ставится нога — наружу или внутрь».

3. BERT лучше воспринимает логично организованный контент, поэтому нужна продуманная структура.

Как это использовать? Добавляйте заголовки (H2, H3, H4) для разделения текста, вставляйте списки и таблицы, чтобы информацию было удобнее воспринимать.

4. «Берт» сделал голосовой поиск более точным. Но устно люди формулируют запросы иначе, чем текстовые — это нужно учитывать.

Как это использовать? Добавляйте в текст вопросительные заголовки — «как», «почему», «что». Пишите в формате «вопрос-ответ». При этом нужны четкие и лаконичные ответы, чтобы попасть в расширенный сниппет.

Пример. «Белые кроссовки можно очистить с помощью мыльного раствора и мягкой щетки. Не используйте отбеливатели, чтобы не повредить материал».

5. BERT продолжает обучаться, и устаревшие статьи могут терять позиции.

Как это использовать? Обновляйте статьи с данными, примерами и статистикой. Добавляйте актуальную информацию, если запросы пользователей изменились. Время от времени меняйте формулировки, чтобы сделать текст более понятным.

💌 Еженедельная рассылка

Подпишитесь на нашу рассылку — раз в неделю будем отправлять на ваш email свежую статью из блога и другие полезные материалы.

Принципы работы алгоритма BERT

Большинство моделей для обработки естественного языка обучаются на размеченных наборах данных, которые составляются лингвистами вручную. А алгоритм BERT был предварительно обучен на неразмеченных текстах — англоязычной «Википедии» и коллекции образцов текстов английского языка Brown Corpus.

За счет самостоятельного обучения (это еще называется unsupervised learning) «Берт» продолжает совершенствоваться при обработке поисковых запросов в Google.

Инструмент использует трансферное обучение — после предварительного обучения на огромных объемах данных модель можно дополнительно обучить для выполнения конкретных задач.

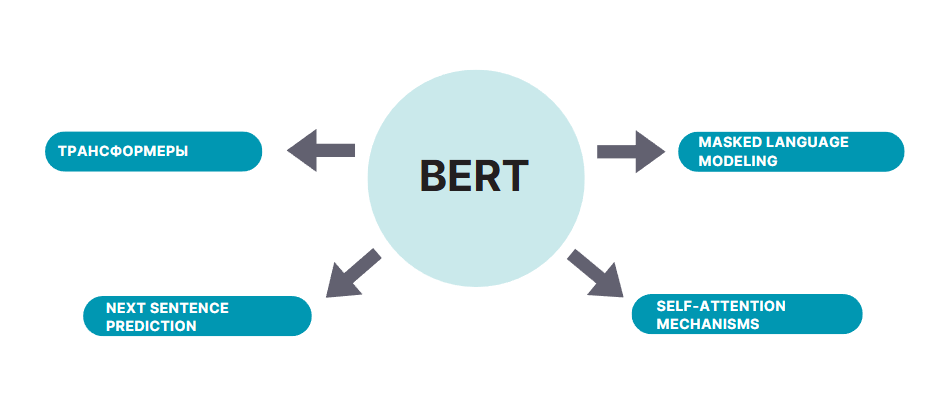

Технологии, лежащие в основе работы BERT:

Трансформеры. С их помощью модель учитывает весь контекст предложения, а не анализирует слова по одному. У более ранних алгоритмов каждому слову соответствовал фиксированный вектор.

Маскированное языковое моделирование (Masked Language Modeling, или MLM). У традиционных моделей с векторным представлением значения для слов фиксированы, из-за этого такие модели менее эффективны при анализе контекста. В «Берт» используется маскирование слов. 15% слов в каждой последовательности заменяется токеном. Затем модель пытается предсказать исходное значение замаскированных слов на основе контекста, предоставляемого другими, не замаскированными словами в последовательности.

Механизм внутреннего внимания (Self-attention mechanism). Инструмент анализирует отношения между словами с учетом окружения. Это важно в сложных предложениях. Например, в запросе «Женщина остановилась у аллеи, потому что на ней росли цветы», нейросеть BERT корректно определяет, что «на ней» относится к слову «аллея», а не «женщина».

Предсказание следующего предложения (Next Sentence Prediction, или NSP). BERT учится различать логически связанные и случайные пары предложений.

Четыре механизма работают параллельно

Где используется поисковый алгоритм Google BERT

Основное применение «Берта» — эффективная интерпретация запросов в поисковике Google. Но компания использует модель и в других проектах:

PatentBERT — классификация патентов;

DocBERT — классификация документов;

BioBERT — анализ медицинских и биологических текстов;

VideoBERT — обработка видео и текста на YouTube;

SciBERT — анализ научных статей;

G-BERT — медицинские рекомендации.

Сравнение алгоритмов BERT и RankBrain: ключевые различия

Помимо «Берта» Google использует алгоритм RankBrain, чтобы улучшить понимание пользовательских запросов и выдавать более релевантные результаты. Хотя оба инструменты связаны с обработкой естественного языка, они выполняют разные задачи и дополняют друг друга.

Google использует обе технологии в зависимости от типа запроса:

«Берт» помогает с разговорными запросами, длинными фразами и сложными формулировками.

RankBrain анализирует новые запросы, синонимы и контекст, основываясь на предыдущих данных.

BERT | RankBrain | |

Тип | Нейросеть (глубокое обучение) | Машинное обучение |

Год запуска | 2019 | 2015 |

Основная задача | Понимание контекста и намерения пользователя | Интерпретация незнакомых запросов через анализ прошлого опыта |

Метод работы | Двунаправленный анализ слов в предложении | Обучение на основе истории запросов и поведения пользователей |

Особенность | Понимает разговорные и длинные запросы | Понимает новые, редкие запросы и синонимы |

Взаимодействие с SEO | Требует качественного, осмысленного контента | Учитывает поведение пользователей на сайте |

Влияние | Влияет на 10% поисковых запросов | Влияет на все запросы, особенно новые |

Что по итогам?

Алгоритм BERT — большой шаг к тому, чтобы поисковые системы понимали естественный человеческий язык, а не искали совпадения по словам. Он уже улучшил качество поиска в Google, сделал чат-ботов умнее и помог автоматизировать анализ текстов.

Маркетологам и SEO-специалистам нужно менять контент под новые требования, потому что алгоритм BERT в 2025 году продолжает развиваться.

Улучшите ваш сайт

Подключите свой сайт к нам, чтобы отслеживать позиции и выявлять ошибки с максимальным комфортом. Вы будете получать уведомления обо всех изменениях на вашем сайте в течение суток — еще до того, как проблема станет серьезной.

ПодключитьFAQ

Что такое BERT и зачем он нужен?

BERT (Bidirectional Encoder Representations from Transformers) — алгоритм, который помогает поисковым системам лучше понимать смысл текста. Он анализирует слова в контексте всего предложения, а не по отдельности. Например, если задать вопрос «Можно ли сделать прививку, если болеешь?», BERT поймет, что речь идет о вакцинации во время болезни, а не о словах «прививка» и «болеешь» по отдельности.

Чем BERT отличается от предыдущих алгоритмов?

Раньше поисковые системы анализировали текст только слева направо или справа налево. BERT читает предложение целиком и учитывает контекст. Например, в запросе «банк данных» он понимает, что речь идет о хранилище информации, а не о финансовом учреждении.

Как BERT влияет на SEO и контент?

Технология оценивает качество и полезность текстов, поэтому простое добавление ключевых слов уже не работает. Важно писать понятные и полезные тексты, которые отвечают на вопросы пользователей, и избегать роботизированных формулировок.

Можно ли обойти BERT с помощью SEO?

В привычном смысле нет. BERT анализирует смысл текста, а не ключевые слова. Лучший способ улучшить видимость сайта — создавать логично структурированный, полезный контент, который написан естественным языком.

Как BERT влияет на голосовой поиск?

BERT улучшает понимание разговорных запросов. Например, раньше поисковик реагировал только на короткие фразы вроде «погода Москва завтра», а теперь корректно обрабатывает естественные вопросы: «Какая погода будет в Москве завтра?»