Содержание

Метатеги robots и x-robots нужны, чтобы указать поисковому роботу, как индексировать страницу. С их помощью можно открывать или закрывать страницу для индексации, а также разрешать или запрещать роботам отслеживать ссылки.

Поисковой робот или краулер сканирует сайт, он автоматически переходит по доступным ссылкам, анализирует содержимое страницы и передает данные на сервер поисковой системы, после чего пополняет выдачу. На непросканированную страницу попасть можно только по прямой ссылке. Указания для индексации сайта прописываются в файле robots.txt.

Метатег robots и файл robots.txt — в чем разница?

Файл robots.txt находится в корневом каталоге сайта, и краулеры начинают сканирование страниц именно с него. Он содержит информацию о том, какие страницы необходимо индексировать, а какие — нет. Помимо отдельных страниц, в файле содержатся указания по индексации отдельных фрагментов: текста, изображений, сниппетов.

Статья по теме: Как составить robots.txt самостоятельно

Метатеги — это строки кода гипертекстовой разметки внутри файла, которые управляют индексацией отдельных страниц. В отличие от robots.txt, у них ограниченная область действия.

Метатег "x-robots-tag" также служит для управления индексацией, но его используют в заголовках HTTP-ответа, а не в HTML-коде страницы. Это позволяет управлять индексацией даже для не-HTML файлов, таких как PDF или изображения.

Метатеги краулеров и их директивы

Принцип работы краулеров у всех поисковых систем одинаков — они индексируют страницы и вносят их в результаты выдачи. Применение метатегов и внутренняя разметка кода для Яндекс и Google будут отличаться. Обе системы используют два основных метатега для настройки индексации страниц, каждый из которых выполняет свою функцию:

robots — определение правил загрузки и индексирования сайта в HTML-коде определенной страницы в элементе head;

X-Robots-Tag — настройка HTTP-заголовка конкретного URL.

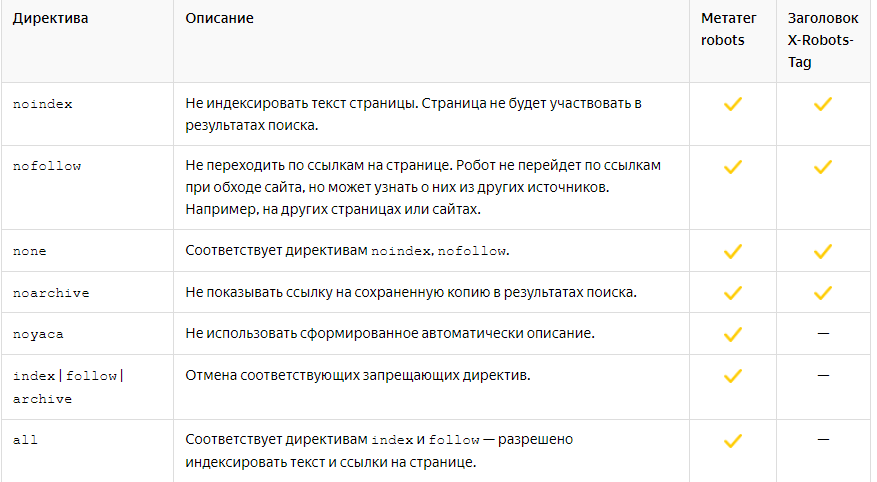

В исходном коде метатега прописывается директива. Она определяет, что вы хотите указать поисковым роботам. Для обоих тегов доступны следующие значения директив:

В Google есть директивы, которых нет в исходном коде Яндекса:

nositelinkssearchbox — убирает окно поиска по сайту в результатах;

indexifembedded — индексация контента, встроенного с помощью тега inframes или его аналога; применяется только совместно с noindex;

max-snippet: [число] — ограничение на количество символов в тексте для отображения в выдаче; 0 — не содержит фрагментов для показа (аналог nosnippet), -1 — Google выбирает оптимальную длину фрагмента самостоятельно;

max-image-preview: [setting] — максимальный размер изображения в выдаче для этой страницы; none — без изображения; standart — размер по умолчанию; large — более крупное, чем стандартное;

max-video-preview: [число] — ограничение длительность фрагмента видео в секундах; 0 — статическое изображение по настройкам max-image-preview; -1 — без ограничений;

notranslate — запрещает перевод страницы в выдаче; если не установить эту директиву, то фрагменты ответов будут отображаться в результатах на другом языке;

noimageindex — запрет на индексацию изображений;

unavailable_after: [date/time] — запрет на индексацию после определенного периода.

Метатег robots

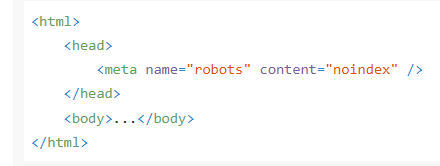

В обеих поисковых системах теги имеют одинаковую структуру:

В значении content прописывается любая нужная директива. Можно использовать сразу несколько директив через запятую.

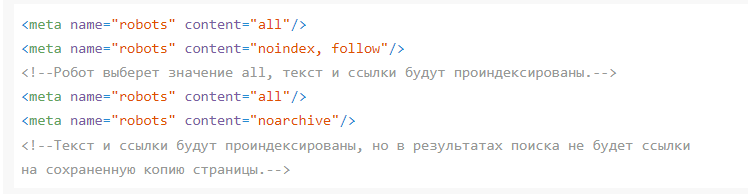

Разрешающие директивы =all включены по умолчанию, поэтому если нет других задач, то и прописывать значение не надо. Если вы используете оба вида директив вместе с запрещающими, то у разрешающих будет приоритет. Например:

Если вы хотите запретить индексацию только для роботов Яндекса, то это прописывается в элементе name:

<meta name= “yandex” content= “noindex” />

В коде с несколькими директивами действует своя логика:

content= “noindex”,”follow” /> — роботам запрещено индексировать страницы, но разрешено переходить по ссылкам;

content= “noindex”,”nofollow” /> — роботы не могут индексировать страницу целиком, включая ссылки; они будут посещать страницу лишь для проверки наличии запрета на индексирование.

content= “index”,”follow” /> — роботы могут индексировать страницу полностью.

Google позволяет также блокировать доступ к другим роботам алгоритма. Настройки по умолчанию указаны для поисковых ботов googlebot, а чтобы исключить из сканирования страницы, например AdsBot, код должен выглядеть так:

<meta name="AdsBot-Google" content="noindex">

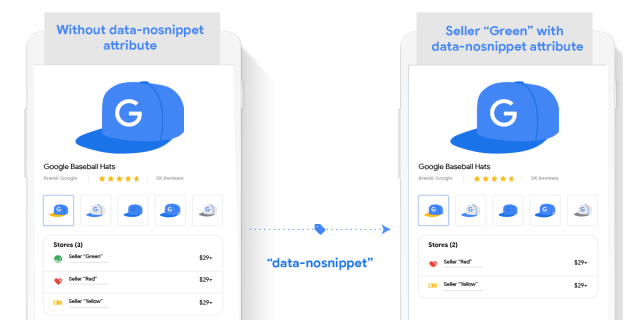

Для настроек на уровне текста в HTML-код необходимо прописать атрибут data-nosnippet.

Так отдельные фрагменты текста можно специально убирать или добавлять в результаты выдачи. Атрибут относится к логическим, поэтому его можно прописывать без значения. Например:

<p>Пример текста из сниппета, который можно показывать <span data-nosnippet>но только не эту часть, пожалуйста</span></p> <div data-nosnippet>и не эту</div> <div data-nosnippet="true">и не эту тоже</div> <div>

Все части HTML-кода должны иметь закрывающие теги и корректную лексику, поэтому работа с метатегами относится к базовму уровню работы с поисковой оптимизацией сайта. Неверное применение может привести к проблемам с отображением нужных страниц в выдаче или появления в ней ненужных. Применение тега robots особенно важно в продвижении крупных сайтов с большим количеством страниц. Он позволяет исключить из индексации все технические страницы и вообще любую информацию не связанную с тем, что вы хотите видеть в выдаче. А расширенные настройки директив Google позволяют убрать из поиска фрагменты текста, изображения и даже перевод страниц.

Метатеги robots также используют на этапе разработки, чтобы случайно не «засветить» данные, убрать дубли, не готовые материалы или служебные сообщения.

X-Robots-Tag

К заголовкам метатегов применяются те же правила, что и для robots. Яндекс поддерживает меньшее количество директив для него. Он не включает:

noyaca;

index [follow] archive;

all.

Их можно добавлять в HTTP-ответы с помощью файлов конфигурации в серверном ПО сайта, поэтому требования к синтаксису исходного кода здесь еще строже, чем у robots. По сути, даже небольшая ошибка может привести к тому, что сайт перестанет работать. Перед тем, как прописать X-Robots-Tag убедитесь в надежных бэкапах, чтобы не потерять данные. Но если вы хотите перестраховаться, попробуйте бессерверную архитектуру приложений типа Edge SEO: она может менять теги на пограничном сервере, не меняя кодовую базу.

Вот, как будет выглядеть тег с директивами noindex и nofollow для файлов PDF в системе Apache в поисковой системе Google:

<Files ~ "\.pdf$"> Header set X-Robots-Tag "noindex, nofollow" </Files>

А так выглядит запрет на индексирование страницы в Яндексе:

HTTP/1.1 200 OK Date: Tue, 25 May 2010 21:42:43 GMT X-Robots-Tag: noindex, nofollow X-Robots-Tag: noarchive

Заголовки X-Robots-Tag действуют в тех случаях, когда недоступны теги robots, например, с его помощью можно запретить индексацию конкретных форматов изображений на всем сайте. Также он доступен для отдельных статических файлов.

Если сканирование запрещено в файле robots.txt, то поисковый робот проигнорирует настройки метатегов. При настройке тегов убедитесь, что страницы, которые вы хотите удалить из индекса, не закрыты через disallow.

Закрывайте от сканирования и индексации любые данные, не прошедшие в релиз. Если же новые страницы с disallow в robots.txt получают органический трафик, то он приходит через 301-редиректы. Трафик будет поступать до тех пор, пока старые страницы находятся в выдаче.

При разработке объемного многостраничного ресурса, например, интернет-магазина, часто используют так называемые «скрытые URL». Предположим, вы заранее подготовились к черной пятнице и сразу выложили эти страницы на сайт, спрятав их через disallow. Если вы хотите презентовать эксклюзив, акцию или особую скидку, это не лучшее решение, поскольку страницы могут попасть в индекс раньше времени, а пользователь увидит акцию, которая еще не работает. Поэтому их лучше не запрещать в robots.txt, а закрывать индексацию через метатеги.

Настройка метатегов не относится к обязательному фактору продвижения, а для ряда случаев ими можно пренебречь. Но базовое понимание принципов их работы и настройки необходимо знать каждому оптимизатору.

Последние изменения Google, которые касаются тегов robots и X-Robots

- Усиление значимости мобильной оптимизации для SEO. С мая 2024 года Google начал жестко индексировать только те сайты, которые доступны для мобильных устройств. Это означает, что сайты без мобильной адаптации могут быть исключены из индексации.

- Введение новых директив в метатег

robots.Google добавил новые директивы, такие какmax-snippet,max-image-previewиmax-video-preview, которые позволяют более точно контролировать отображение фрагментов контента в результатах поиска. - Рекомендации по управлению фасетной навигацией. Google выпустил официальную документацию по управлению фасетной навигацией, которая может создавать множество URL-адресов и перегружать серверы. Рекомендуется блокировать некритические фильтры с помощью файла

robots.txtили атрибутовrel="nofollow", а для критически важных фильтров использовать канонические теги и правильно обрабатывать ошибки 404.

Несмотря на изменения в алгоритмах поисковых систем и факторах ранжирования, за последние несколько лет система настройки метатегов robots и X-Robots-Tag практически не изменились. Освоение этих инструментов подойдет для знакомства с профессией начинающим специалистам, ведь с их помощью проще понять принцип работы остальных тегов.